Rivelate le cinque competenze chiave del modello, la funzionalità di comprensione delle immagini appare misteriosamente: il lancio ufficiale di o1 è imminente

OpenAIha presentato al London Developer Day cinque principali competenze del modello o1 e la funzionalità di comprensione delle immagini. Altman ha anche rivelato che il modello delle immagini subirà presto miglioramenti significativi. Durante le dimostrazioni dal vivo di o1, sono state costruite applicazioni come il controllo di droni, l'effettuazione di chiamate telefoniche e la spiegazione del sistema solare, suscitando entusiasmo in tutti gli sviluppatori. Recentemente, sembra che la versione completa della capacità di comprensione delle immagini di o1 sia stata divulgata in anticipo. Gli utenti hanno riferito di aver ottenuto la nuova funzione di comprensione delle immagini di o1, e una grande ondata di test multimodali di o1 ha invaso l'intera rete. Una serie di evidenze suggerisce che il lancio ufficiale di o1 potrebbe essere imminente.

I modelli di IA vengono costantemente aggiornati e ottimizzati, come XXAI che ottimizza i modelli, integra le piattaforme di IA più popolari e risolve tutti i problemi in modo univoco senza aumentare i prezzi. Anche nuovi tipi di modelli di IA vengono lanciati in grandi quantità, proprio come il modellored_pandache aveva causato sensazione in precedenza. Prestiamo molta attenzione ai modelli di IA sul mercato e accogliamo il loro arrivo con entusiasmo!

Il modello o1 entra in scena

All'OpenAI London Developer Day, Romain Huet, capo dell'esperienza sviluppatore, ha presentato il modello o1 sul palco.

Alcune delle dimostrazioni mostrate includono:

Utilizzando o1 mini in combinazione con Cursor, è stata costruita in meno di 2 minuti un'applicazione interattiva che permette il controllo di un drone e la realizzazione di una manovra di rotazione.

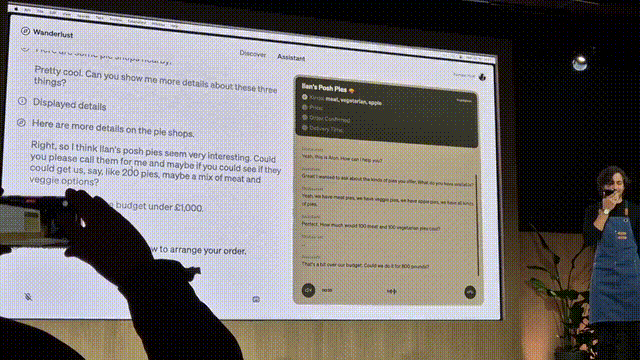

Utilizzando RealTimeAPI, è stato sviluppato un agente vocale di IA in tempo reale per effettuare ordinazioni telefoniche ai fornitori.

Nuove funzionalità del modello o1 rivelate

Olivier Godement, capo del dipartimento prodotti di OpenAI, ha fornito un'anteprima delle nuove funzionalità del modello o1 durante il London Developer Day. Ciò include chiamate a funzioni, messaggi per sviluppatori, streaming, output strutturati e comprensione delle immagini in cinque aree. Inoltre, Altman ha dichiarato che il modello delle immagini avrà presto miglioramenti significativi e che stanno costantemente creando nuove capacità. Siamo molto entusiasti per questo.

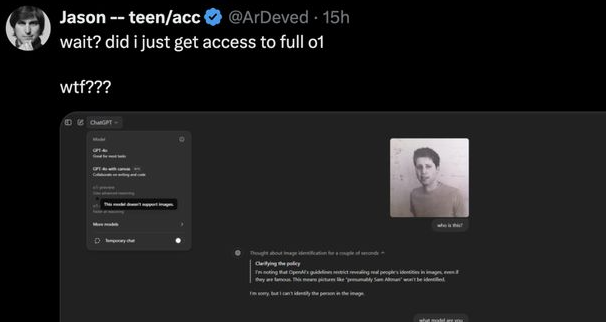

Comparsa misteriosa della comprensione delle immagini di o1

La nuova funzionalità completa di comprensione delle immagini del modello o1 è stata divulgata prima del previsto. Gli utenti hanno riferito che o1 può riconoscere immagini, ragionare e generare riassunti, e hanno loro stessi ottenuto la nuova funzionalità di comprensione delle immagini di o1.

Tuttavia, è interessante notare che la funzionalità di comprensione delle immagini di o1 non è stata ufficialmente rilasciata. Potrebbe essere che il microservizio sottostante di OpenAI abbia avuto un guasto e non sia stato ancora sistemato. Tuttavia, gli utenti hanno sfruttato l'occasione per iniziare una vasta serie di test sulla comprensione delle immagini di o1.

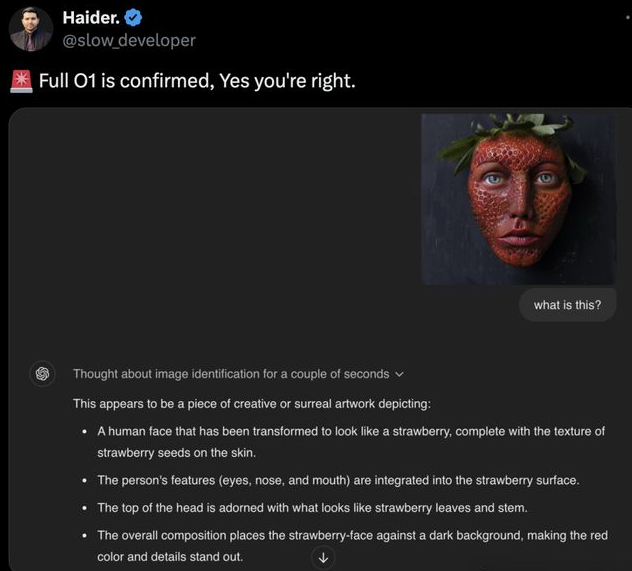

Ecco alcuni risultati dei test:

Il modello o1 ha spiegato perfettamente il contenuto dell'immagine.

Analisi di una mappa dei cavi in fibra ottica sottomarini: il modello o1 ha correttamente indicato, dopo diversi passaggi di ragionamento, che questi cavi attraversano gli oceani e collegano diversi continenti e regioni del mondo.

Il modello o1 ha anche le sue debolezze

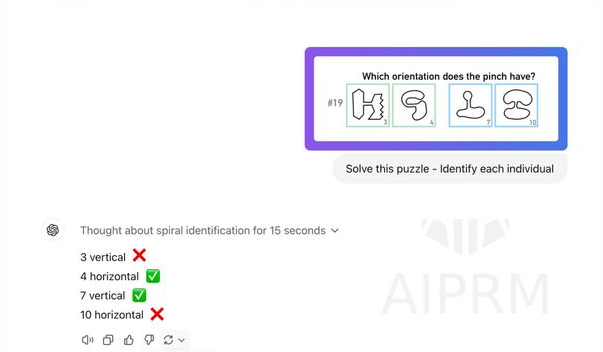

La velocità di ragionamento della comprensione delle immagini di o1 è impressionante, ma abbiamo anche scoperto che il modello o1 non ha ancora superato completamente l'immagine e non è pronto per una comprensione multimodale completa.

o1 non può ancora "leggere" i video.

Mostra anche una certa incapacità nel risolvere problemi visivi.

Sessione di domande e risposte con Altman

Domanda: Dobbiamo aspettare modelli come o1 o piuttosto modelli su scale più grandi?

Altman: Spero di migliorare in modo esaustivo le prestazioni dei grandi modelli di linguaggio, ma questa strategia di ragionamento è molto importante. Non è appropriato divulgare troppi dettagli, ma prevedo avanzamenti rivoluzionari nel campo dei modelli delle immagini.

Domanda: A che livello di integrazione tecnica ci si aspetta di arrivare? Come dovrebbero piano le startup di IA che stanno creando prodotti basati su OpenAI?

Altman: Consiglio ai fondatori di creare aziende che approfittino pienamente dei vantaggi attuali dei grandi modelli di linguaggio e che abbiano più spazio per lo sviluppo durante i futuri aggiornamenti del modello.

Domanda: Cos'è un agente di IA?

Altman: Un sistema capace di accettare compiti a lungo termine e che richiede una supervisione minima durante l'esecuzione. Credo che la definizione data da Harrison Chase nel suo blog di Langchain sia più rigorosa, ma dal punto di vista commerciale, questa definizione è molto pratica.

Domanda: Cosa possono fare gli agenti di IA?

Altman: Possono portare a termine compiti che gli umani non possono completare a causa di limitazioni di capacità, ad esempio chiamare simultaneamente 300 ristoranti, permettendo agli agenti IA di parlare con ogni ristorante e raccogliere Arsenale informazioni in tempo reale. Oppure sono come colleghi incredibilmente intelligenti e altamente qualificati a cui si possono ulteriormente affidare compiti per due giorni o una settimana con fiducia. Onestamente, detesto la parola "agentic". Non creiamo una nuova parola insieme!