Les cinq compétences clés du modèle dévoilées, fonctionnalité de compréhension d'image apparaît mystérieusement : le lancement officiel de o1 est imminent

OpenAI a présenté lors de la London Developer Day les cinq principales compétences du modèle o1 ainsi que la fonctionnalité de compréhension d'image. Altman a également révélé que le modèle d'image connaîtrait bientôt des améliorations significatives. Lors de démonstrations en direct du o1, des applications telles que le pilotage de drones, les commandes téléphoniques et l'explication du système solaire ont été construites, suscitant l'enthousiasme de tous les développeurs. Récemment, il semble que la version complète de la capacité de compréhension d'image du o1 ait été divulguée en avance. Les utilisateurs ont rapporté avoir obtenu la nouvelle fonctionnalité de compréhension d'image du o1, et une grande vague de tests multimodaux du o1 a envahi l'ensemble d'Internet. Une série de preuves indique que le lancement officiel du o1 pourrait être imminent.

Les modèles d'IA sont constamment mis à niveau et optimisés, tout comme XXAI, qui optimise les modèles, intègre les plateformes d'IA populaires et résout tous les problèmes de manière unifiée sans augmenter les prix. De nouveaux types de modèles d'IA sont également lancés en grand nombre, tout comme le modèle red_panda qui avait fait sensation auparavant. Nous portons une grande attention aux modèles d'IA sur le marché et accueillons leur arrivée avec enthousiasme !

Le modèle o1 fait son entrée sur scène

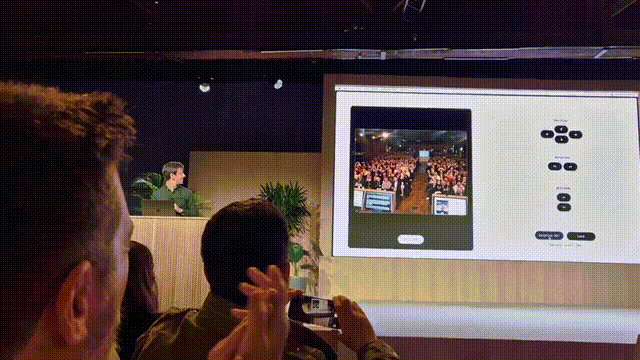

Lors de la London Developer Day d'OpenAI, Romain Huet, responsable de l'expérience développeur, a présenté le modèle o1 sur scène.

Voici quelques démonstrations présentées sur place :

En utilisant o1 mini en liaison avec Cursor, une application interactive permettant de piloter un drone et de réaliser une figure arrièrecombinée a été construite en moins de 2 minutes.

En utilisant RealTimeAPI, un agent IA vocal en temps réel a été développé pour passer des commandes téléphoniques auprès des vendeurs.

Nouvelles fonctionnalités du modèle o1 révélées

Olivier Godement, responsable du département produit chez OpenAI, a donné un aperçu des nouvelles fonctionnalités du modèle o1 lors de la London Developer Day. Cela inclut les appels de fonctions, les messages aux développeurs, le streaming, les sorties structurées et la compréhension d'image dans cinq domaines. De plus, Altman a déclaré que le modèle d'image connaîtrait bientôt des améliorations significatives et qu'ils créent constamment de nouvelles percées. Nous attendons cela avec beaucoup d'enthousiasme.

Apparition mystérieuse de la compréhension d'image du o1

La nouvelle fonctionnalité complète de compréhension d'image du modèle o1 a été divulguée en avance. Les utilisateurs ont rapporté que le modèle o1 pouvait reconnaître des images, effectuer des raisonnements et faire des résumés, et ils ont euxmêmes obtenu la nouvelle fonctionnalité de compréhension d'image du o1.

Cependant, il est intéressant de noter que la fonctionnalité de compréhension d'image du o1 n'a pas été officiellement publiée. Il se pourrait que le microservice sousjacent d'OpenAI ait planté et n'ait pas encore été réparé. Néanmoins, les utilisateurs ont profité de l'occasion pour lancer une grande série de tests de compréhension d'image du o1.

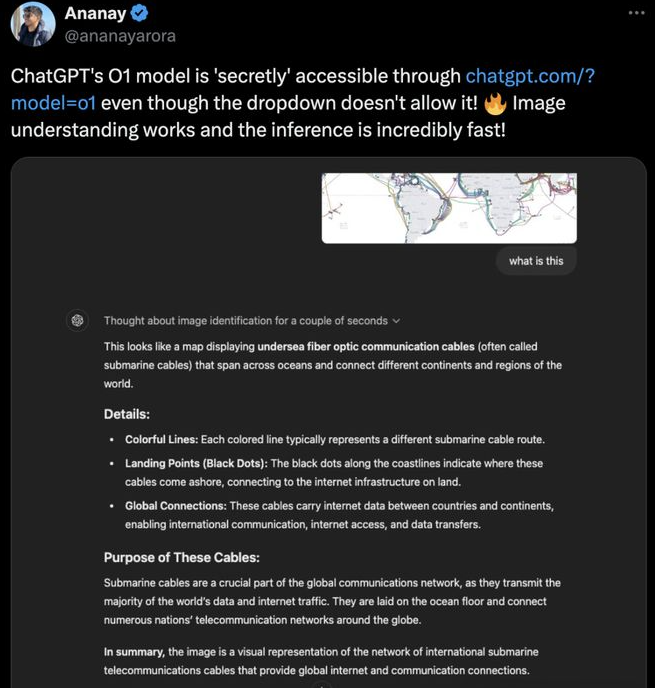

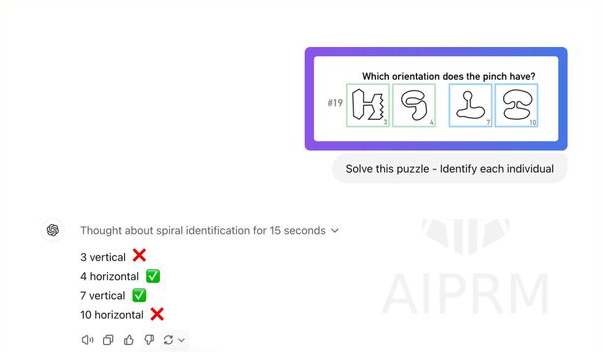

Voici quelques résultats des tests :

Le modèle o1 expliquait parfaitement ce que l'image représentait.

Analyse d'une carte des câbles de fibre optique sousmarins : le modèle o1 a correctement indiqué après plusieurs étapes de raisonnement que ces câbles traversent les océans et connectent différentes continents et régions du monde.

Le modèle o1 a aussi ses faiblesses

La vitesse de raisonnement de la compréhension d'image du o1 est impressionnante, mais nous avons également constaté que le modèle o1 n'a pas encore complètement surpassé l'image et n'est pas encore prêt pour une compréhension multimodale complète.

Le modèle o1 ne peut toujours pas "lire" des vidéos.

Il montre également une certaine impuissance dans la résolution des problèmes visuels.

Session de questionsréponses avec Altman

Question : Devonsnous attendre des modèles comme o1 ou plutôt des modèles de plus grande envergure ?

Altman : J'espère améliorer de manière exhaustive les performances des grands modèles de langage, mais cette approche de raisonnement est très importante. Il n'est pas approprié de divulguer trop de détails, mais je prévois des avancées révolutionnaires dans le domaine des modèles d'image.

Question : À quel niveau d'intégration technique pensezvous arriver ? Comment les startups IA qui construisent des produits basés sur OpenAI devraientelles planifier ?

Altman : Je conseille aux fondateurs de créer des entreprises qui exploitent pleinement les avantages actuels des grands modèles de langage tout en ayant plus d'espace pour le développement lors des futures mises à niveau des modèles.

Question : Qu'estce qu'un agent IA ?

Altman : Un système capable d'accepter des tâches à long terme et nécessitant une supervision minimale pendant son exécution. Je pense que la définition donnée par Harrison Chase dans son blog Langchain est plus rigoureuse, mais d'un point de vue commercial, cette définition est très pratique.

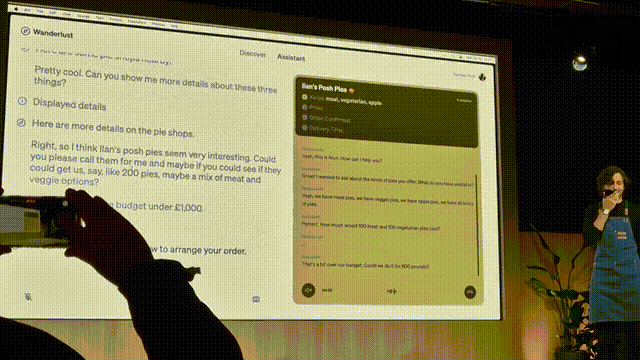

Question : Que peuvent faire les agents IA ?

Altman : Ils peuvent accomplir des tâches que les humains ne peuvent pas terminer en raison de limitations de capacités, par exemple appeler simultanément 300 restaurants, permettant ainsi aux agents IA de converser avec chaque restaurant et de collecter des informations en temps réel. Ou encore, ils sont comme des collègues extrêmement intelligents et hautement qualifiés auxquels on peut confier des tâches pendant deux jours ou une semaine en toute confiance. Honnêtement, je déteste le mot "agentic". Ne pas agir ensemble pendant la discussion et la réflexion, puis ne pas créer un nouveau mot ensemble !