Se revelan las cinco competencias clave del modelo, la funcionalidad de comprensión de imágenes aparece misteriosamente: el lanzamiento oficial de o1 está cerca

OpenAI presentó en el London Developer Day las cinco competencias principales del modelo o1 y la funcionalidad de comprensión de imágenes. Altman también reveló que el modelo de imágenes tendrá mejoras significativas pronto. Durante las demostraciones en vivo de o1, se construyeron aplicaciones como el control de drones, las llamadas telefónicas y la explicación del sistema solar, lo que entusiasmó a todos los desarrolladores. Recientemente, parece que la capacidad completa de comprensión de imágenes de o1 se filtró prematuramente. Los usuarios informaron haber obtenido la nueva funcionalidad de comprensión de imágenes de o1, y una gran ola de pruebas multimodales de o1 ha inundado la web. Una serie de pruebas indica que el lanzamiento oficial de o1 está a punto.

Los modelos de IA se actualizan y optimizan constantemente, como XXAI, que optimiza modelos, integra plataformas de IA populares y resuelve todos los problemas de forma unificada sin aumentar los precios. También se están lanzando nuevos modelos de IA a gran escala, como el modelo red_panda que causó sensación anteriormente. Estamos muy atentos a los modelos de IA en el mercado y recibimos su llegada con entusiasmo.

El modelo o1 entra en escena

En el OpenAI London Developer Day, Romain Huet, responsable de la experiencia del desarrollador, presentó el modelo o1 en el escenario.

Algunas de las demostraciones mostradas fueron:

Usando o1 mini junto con Cursor, se construyó en menos de 2 minutos una aplicación interactiva que permitía controlar un dron y realizar una voltereta.

Usando RealTimeAPI, se desarrolló un agente de IA de voz en tiempo real para realizar pedidos telefónicos a vendedores.

Nuevas funcionalidades del modelo o1 reveladas

Olivier Godement, responsable de productos en OpenAI, ofreció una vista previa de las nuevas funcionalidades del modelo o1 en el London Developer Day. Esto incluye llamadas a funciones, mensajes para desarrolladores, streaming, salidas estructuradas y comprensión de imágenes en cinco áreas. Además, Altman declaró que el modelo de imágenes tendrá mejoras significativas pronto y que están constantemente desarrollando nuevas capacidades. Estamos muy ilusionados con ello.

Aparición misteriosa de la comprensión de imágenes de o1

La nueva capacidad completa de comprensión de imágenes de o1 se filtró prematuramente. Los usuarios informaron haber obtenido la nueva funcionalidad de comprensión de imágenes de o1, y el modelo puede reconocer imágenes, realizar razonamientos y generar resúmenes.

Sin embargo, es interesante destacar que la funcionalidad de comprensión de imágenes de o1 no se ha lanzado oficialmente. Es posible que el microservicio subyacente de OpenAI haya fallado y no haya sido reparado. De todos modos, los usuarios aprovecharon la oportunidad para realizar un gran número de pruebas con la comprensión de imágenes de o1.

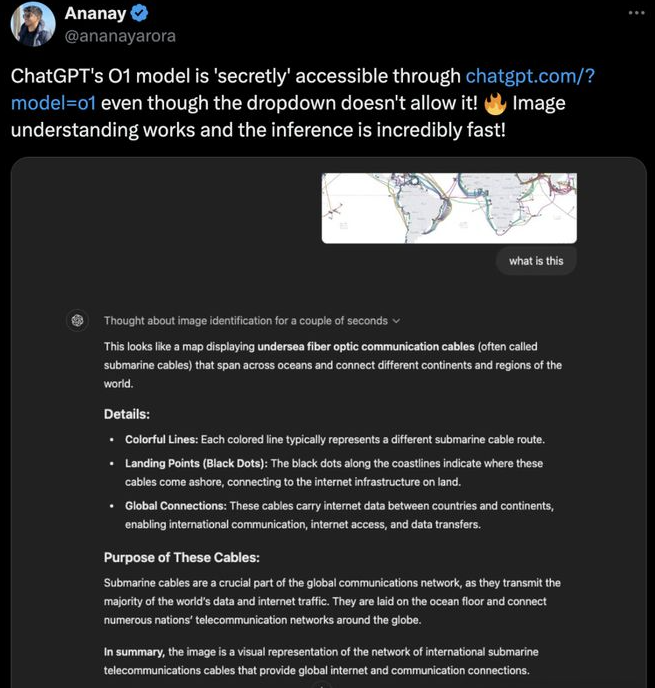

Aquí hay algunos resultados de las pruebas:

El modelo o1 explicaba perfectamente lo que mostraba la imagen.

Análisis de un mapa de cables de fibra óptica submarinos: el modelo o1 indicó con precisión, tras varios pasos de razonamiento, que estos cables atraviesan los océanos y conectan diferentes continentes y regiones del mundo.

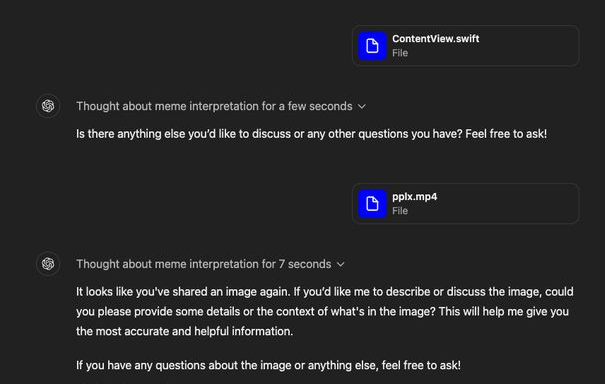

El modelo o1 también tiene debilidades

La velocidad de razonamiento de la comprensión de imágenes de o1 es impresionante, pero también hemos descubierto que el modelo o1 todavía no ha superado por completo la imagen y no está listo para una comprensión multimodal completa.

El modelo o1 todavía no puede "leer" vídeos.

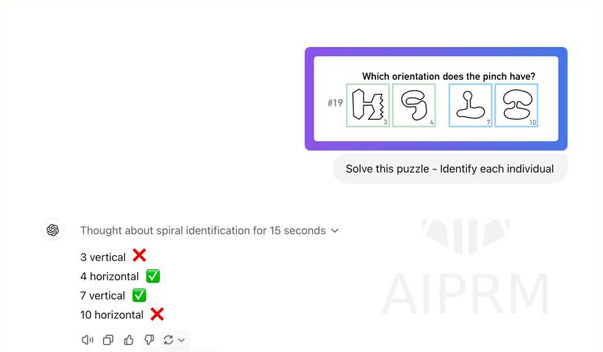

También muestra cierta incapacidad para resolver problemas visuales.

Sesión de preguntas y respuestas con Altman

Pregunta: ¿Deberíamos esperar modelos como o1 o modelos de mayor escala?

Altman: Espero mejorar ampliamente el rendimiento de los grandes modelos de lenguaje, pero este enfoque de razonamiento es muy importante. No es propicio revelar muchos detalles, pero preveo avances revolucionarios en el ámbito de los modelos de imagen.

Pregunta: ¿Qué nivel de integración técnica se espera alcanzar? ¿Cómo deberían planificar las startups de IA que construyen productos basados en OpenAI?

Altman: Recomiendo a los fundadores construir empresas que aprovechen al máximo las ventajas actuales de los grandes modelos de lenguaje y que tengan más margen para el desarrollo en futuras actualizaciones de modelos.

Pregunta: ¿Qué es un agente de IA?

Altman: Un sistema capaz de asumir tareas a largo plazo y que requiere una supervisión mínima durante su ejecución. Creo que la definición de Harrison Chase en su blog de Langchain es más precisa, pero desde el punto de vista comercial, esta definición es muy práctica.

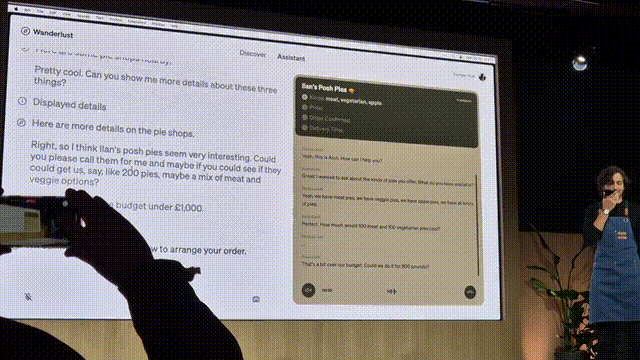

Pregunta: ¿Qué pueden hacer los agentes de IA?

Altman: Pueden realizar tareas que los humanos no pueden completar debido a limitaciones de capacidad, como llamar a 300 restaurantes a la vez, haciendo que los agentes de IA hablen con cada uno y recopilen información en tiempo real. O bien, son como colegas extremadamente inteligentes y cualificados a los que puedes confiar tareas durante dos días o una semana con confianza. Sinceramente, no me gusta la palabra "agentic". Vamos a discutir y pensar juntos para crear una nueva palabra.