Meta 发布 Llama 3.2 1B和3B模型的量化版:降低功耗,提升移动设备的应用潜力

在人工智能日新月异的今天,Meta 于2024年10月24日正式发布了 Llama 3.2 1B 和 Llama 3.2 3B 模型的量化版本。这一新版本是继今年9月开源Llama 3.2模型之后的重要进展,标志着Meta在优化深度学习模型方面迈出了更大一步。随着移动设备应用需求的提升,量化模型的重要性愈发突出。

量化模型的显著优势

经过量化处理后的 Llama 3.2 1B 模型在多个方面都有显著改进。首先,模型大小平均减少56%,这意味着在相同硬件条件下,用户能够更快速地加载和运行模型。其次,在RAM使用量方面,平均减少了41%,这对于资源有限的移动设备尤其重要。这些改进不仅使模型的速度提高了2到4倍,最大程度上提升了用户体验,还降低了运行所需的能耗,使得 Llama 3.2 1B 更加适合各种轻量化应用场景。

简单来说,模型量化是一种高度技术化的过程,它将浮点数模型转换为定点数模型。这一过程帮助我们在压缩模型的同时减少复杂性,使得深度学习模型能够在性能较弱的移动设备上高效运行。随着越来越多的智能应用进入移动设备,量化模型的价值愈加明显。

探索量化的技术方法

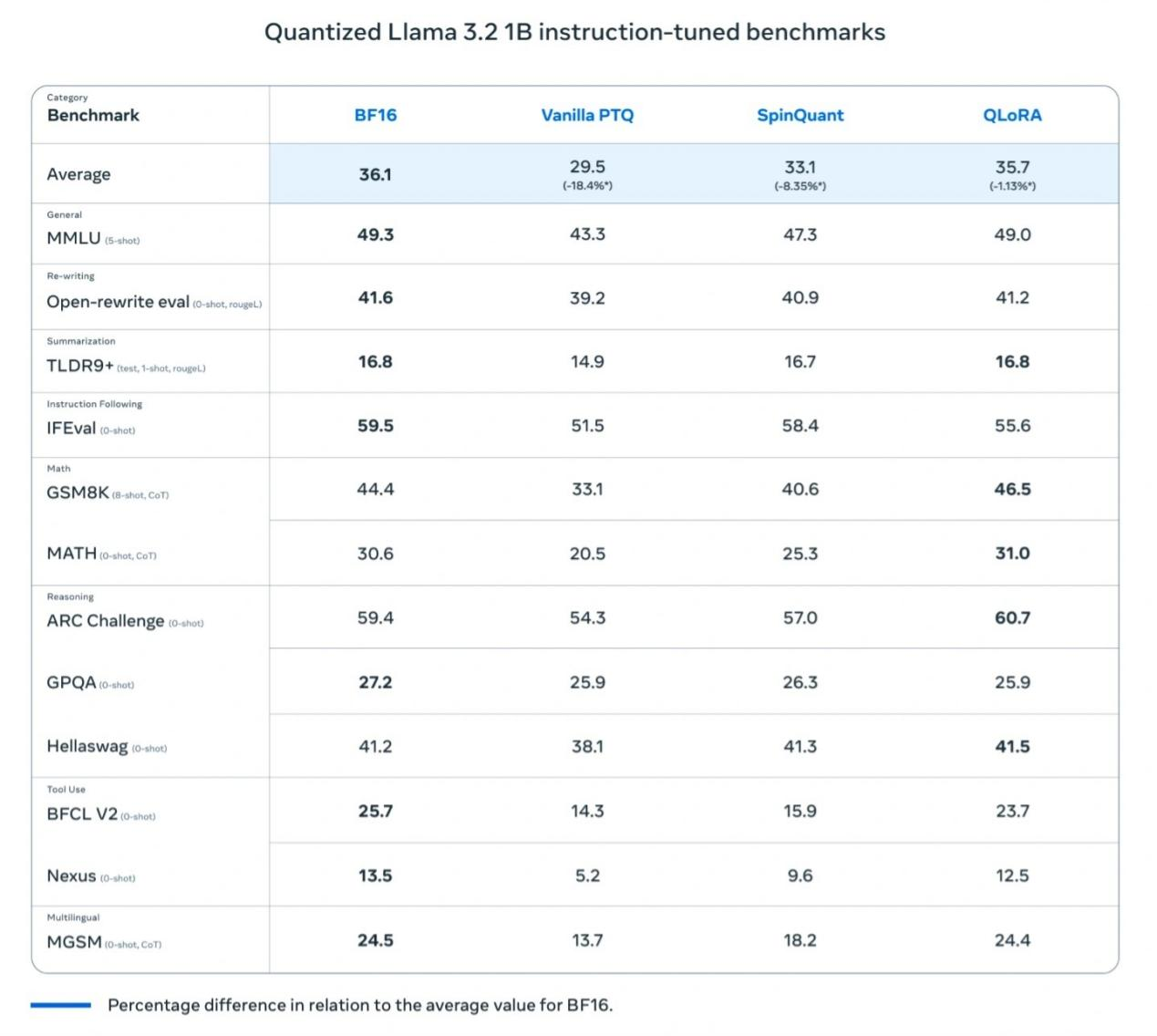

为了确保 Llama 3.2 1B 在量化过程中保持高性能,Meta 主要采用了两种方法:

量化感知训练(QAT):这种方法重视模型的准确性,确保在量化后模型仍具有高精度。

后训练量化(SpinQuant):重点关注模型的可移植性,使得 Llama 3.2 1B 可以兼容多种设备,以满足各种不同的使用需求。

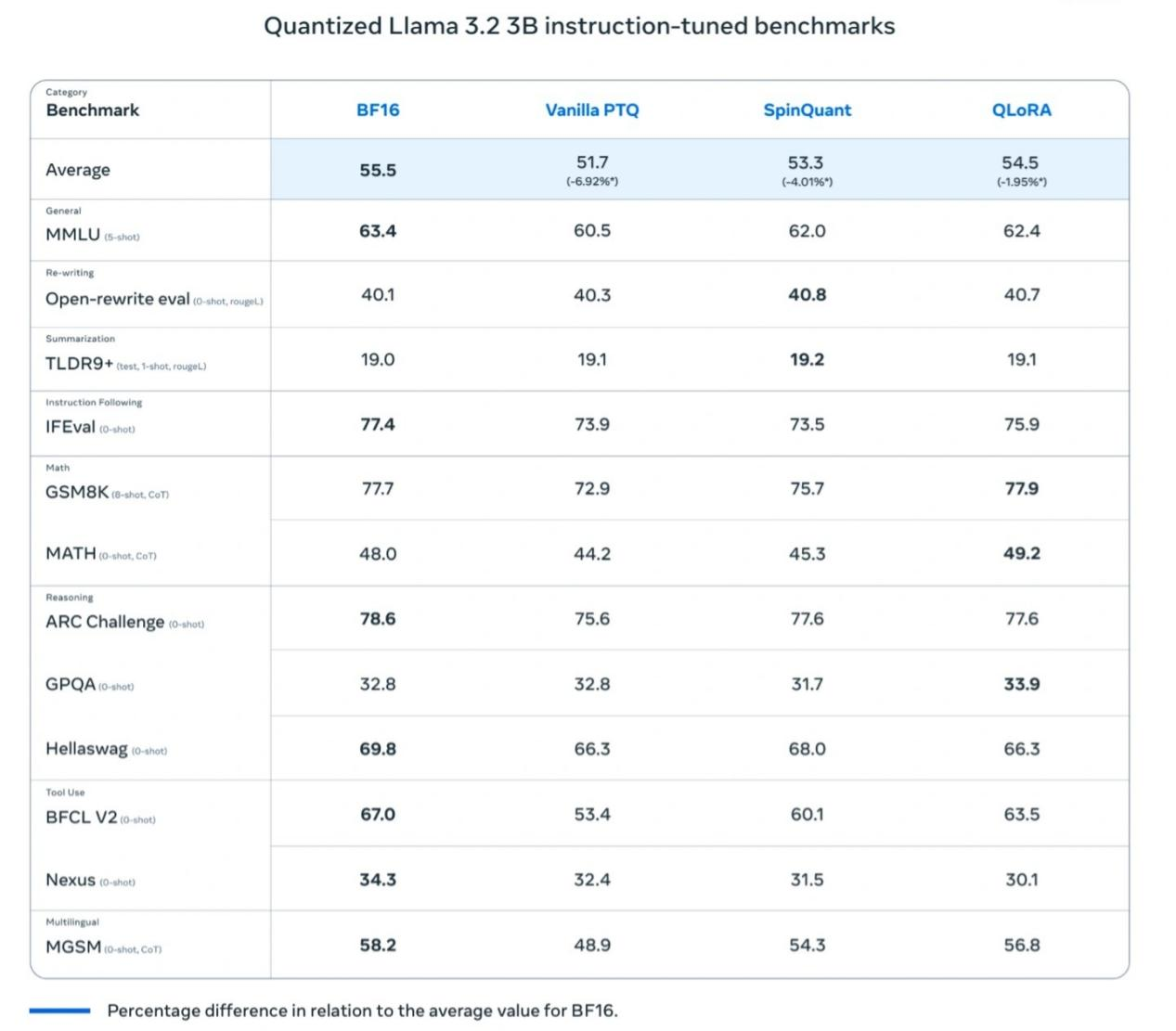

此番发布,Meta 还推出了各两款针对 Llama 3.2 1B 和 Llama 3.2 3B 的量化版本:

Llama 3.2 1B QLoRA

Llama 3.2 1B SpinQuant

Llama 3.2 3B QLoRA

Llama 3.2 3B SpinQuant

性能对比与实际应用

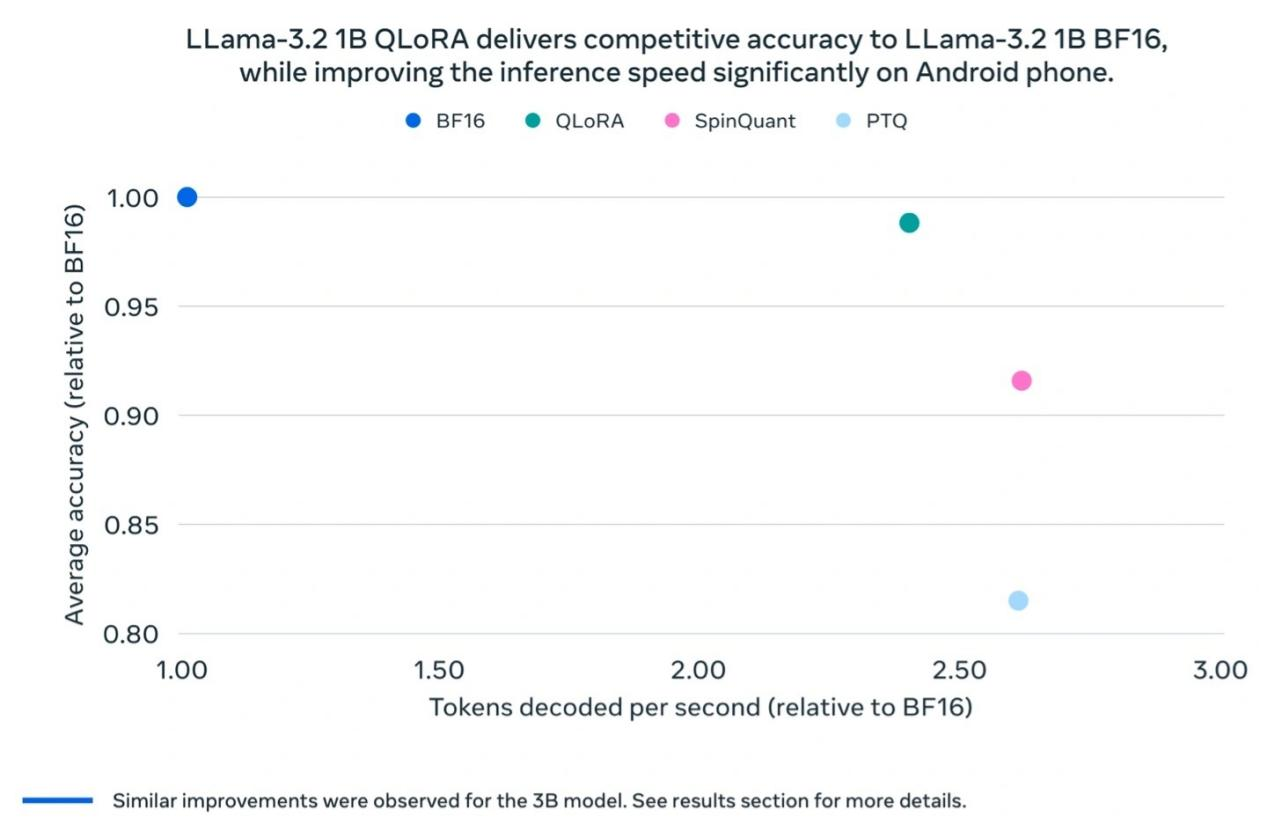

Meta 测试发现,量化后的 Llama 3.2 1B 模型在速度、RAM占用和功耗方面,相较于Llama BF16 模型来说都有显著的提升,同时保持与 Llama BF16 版本几乎相同的精度。尽管量化后的模型支持的Token数量限制在8000个(原版支持12.8万个),但基准测试结果显示,量化版本的实际表现依然接近Llama BF16,大大增强了其实用性。

Meta 还在多个移动平台(包括一加12、三星 S24+/S22 以及未公开型号的苹果 iOS 设备)上进行了实地测试,结果显示“运行良好”,这为 Llama 3.2 1B 模型在现实应用中的成功奠定了基础。

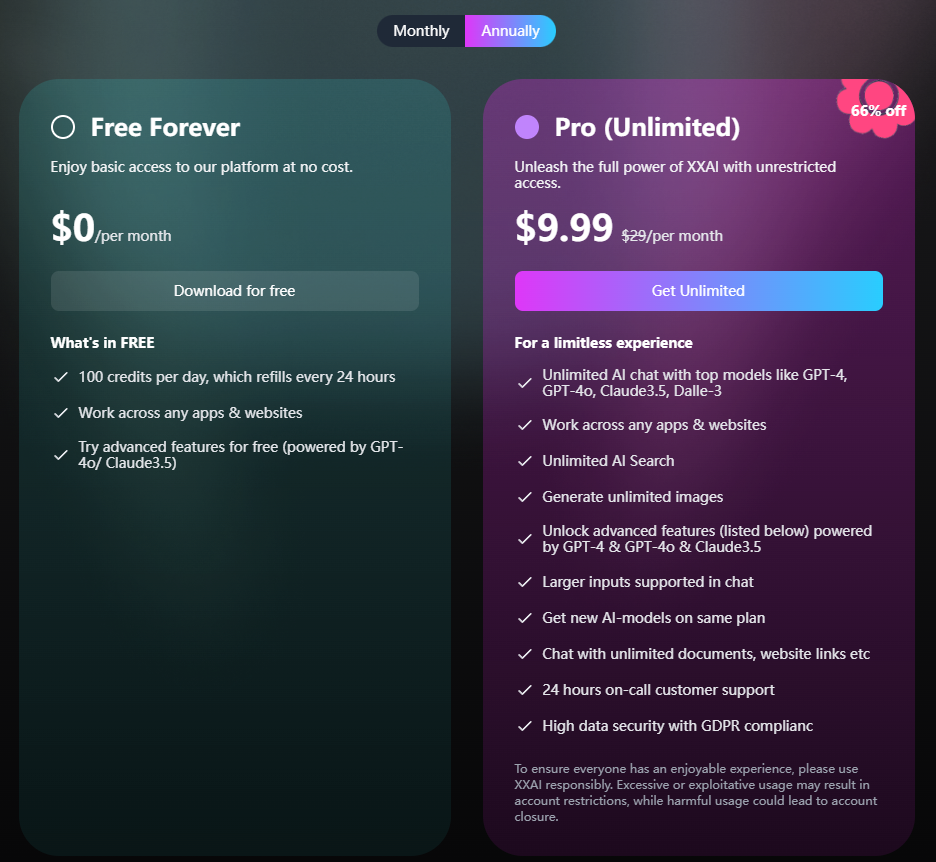

XXAI即将引进更多AI模型

AI助手软件XXAI马上要迎来一波大更新。在这次更新中,XXAI将引进更多顶级的AI模型,其中不仅有文章中提到的Llama 3.2 1B和Llama 3.2 3B,还有Gemini pro 1.5、Grok2、Claude 3 Opus这些市面上排名靠前的AI模型。重要的是价格方面,XXAI在价格上始终保持不变,年度计划每月仅需9.9美元,用实惠的价格给用户提供无限制访问顶级AI 的机会。

结语

Llama 3.2 1B 和 Llama 3.2 3B 的量化版本是在提升性能和能效之间取得成功平衡的典范。这一创新将推动人工智能技术在移动设备上的广泛应用,使得越来越多的智能应用得以在资源受限的设备上顺畅运行。随着Meta不断探索和突破,未来的智能设备无疑将在各个领域中发挥更大的作用。