Meta lance des versions quantifiées des modèles Llama 3.2 1B et 3B : Réduction de la consommation d'énergie et amélioration du potentiel d'application sur les appareils mobiles

Dans le monde en constante évolution de l'intelligence artificielle, Meta a officiellement lancé le 24 octobre 2024 des versions quantifiées des modèles Llama 3.2 1B et Llama 3.2 3B. Cette nouvelle version représente une avancée importante après la publication en open source du modèle Llama 3.2 en septembre de cette année, marquant un pas de plus pour Meta dans l'optimisation des modèles d'apprentissage profond. Avec l'augmentation de la demande d'applications pour appareils mobiles, l'importance des modèles quantifiés devient de plus en plus évidente.

Avantages significatifs des modèles quantifiés

Après le processus de quantification, le modèle Llama 3.2 1B présente des améliorations significatives dans plusieurs aspects. Tout d'abord, la taille du modèle est réduite en moyenne de 56%, ce qui signifie que les utilisateurs peuvent charger et exécuter le modèle plus rapidement dans les mêmes conditions matérielles. Deuxièmement, en termes d'utilisation de la RAM, elle est réduite en moyenne de 41%, ce qui est particulièrement important pour les appareils mobiles aux ressources limitées. Ces améliorations augmentent non seulement la vitesse du modèle de 2 à 4 fois, maximisant l'expérience utilisateur, mais réduisent également la consommation d'énergie nécessaire au fonctionnement, rendant Llama 3.2 1B plus adapté à divers scénarios d'applications légères.

En termes simples, la quantification du modèle est un processus hautement technique qui convertit les modèles à virgule flottante en modèles à virgule fixe. Ce processus nous aide à compresser le modèle tout en réduisant sa complexité, permettant aux modèles d'apprentissage profond de fonctionner efficacement sur des appareils mobiles moins performants. Alors que de plus en plus d'applications intelligentes entrent dans les appareils mobiles, la valeur des modèles quantifiés devient de plus en plus évidente.

Exploration des méthodes techniques de quantification

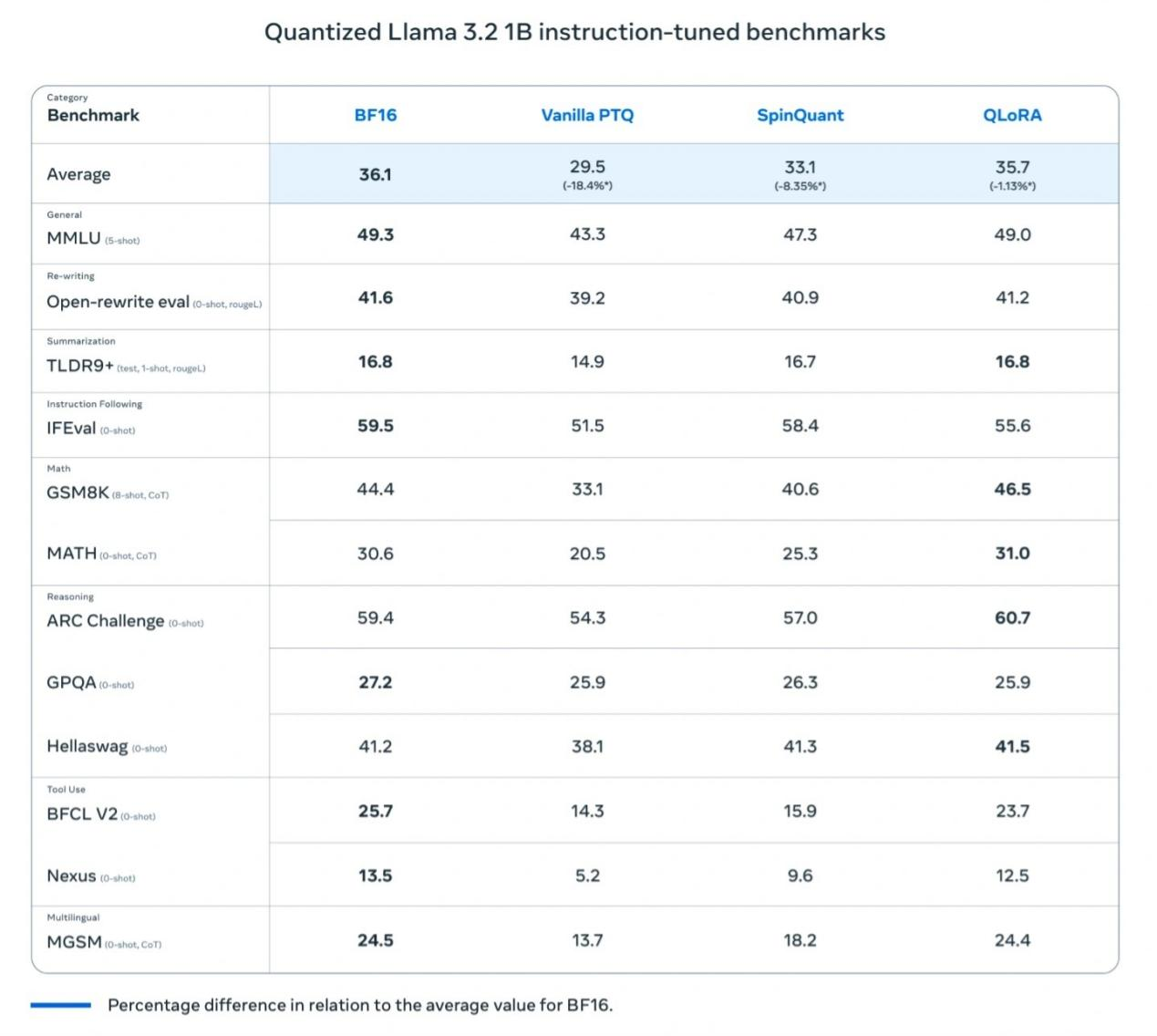

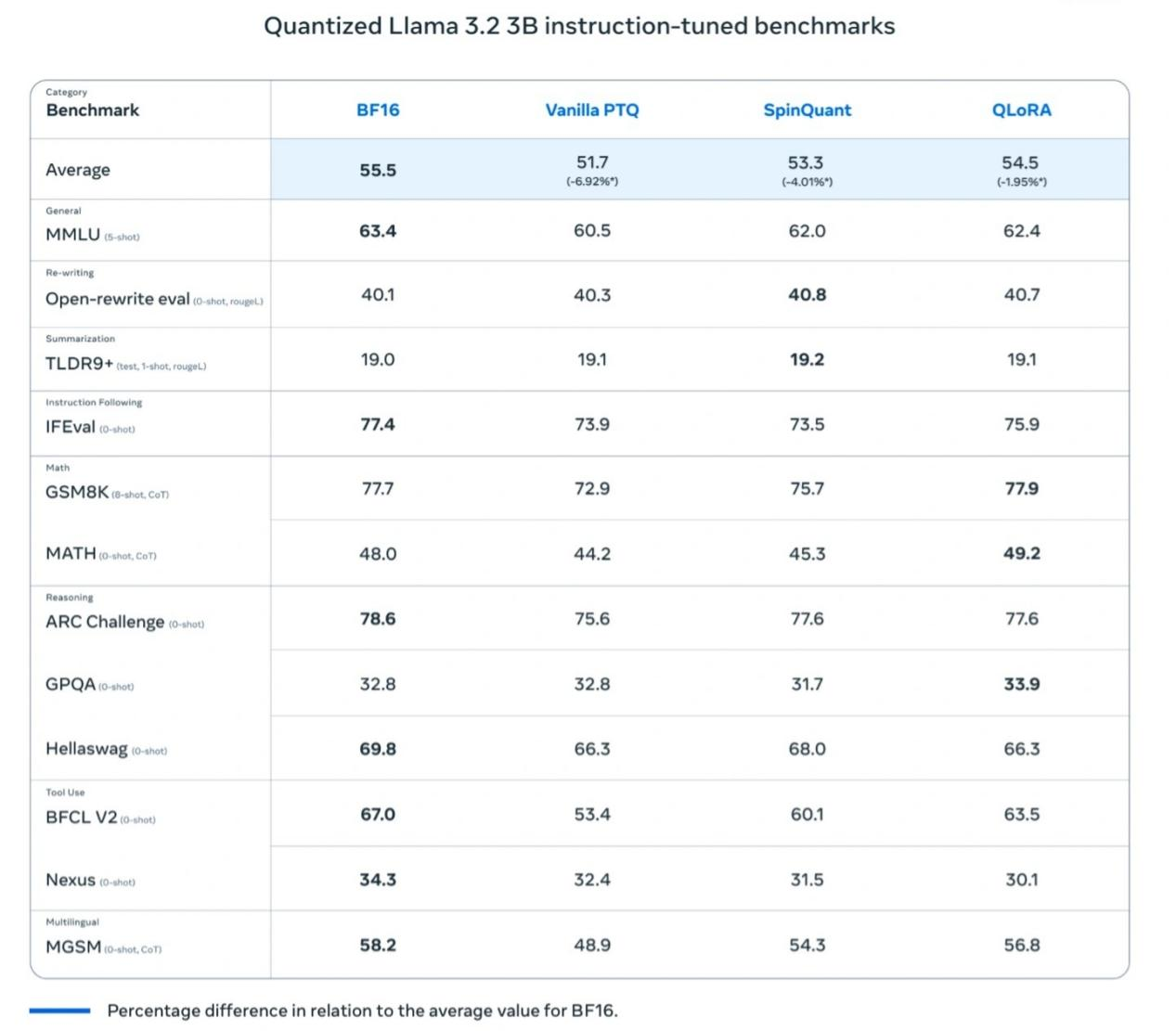

Pour s'assurer que Llama 3.2 1B maintienne des performances élevées pendant le processus de quantification, Meta a principalement utilisé deux méthodes :

Quantization-Aware Training (QAT) : Cette méthode met l'accent sur la précision du modèle, assurant que le modèle conserve une haute précision après la quantification.

Post-Training Quantization (SpinQuant) : Elle se concentre sur la portabilité du modèle, permettant à Llama 3.2 1B d'être compatible avec divers appareils pour répondre à différents besoins d'utilisation.

Lors de cette publication, Meta a également lancé deux versions quantifiées pour Llama 3.2 1B et Llama 3.2 3B :

Llama 3.2 1B QLoRA

Llama 3.2 1B SpinQuant

Llama 3.2 3B QLoRA

Llama 3.2 3B SpinQuant

Comparaison des performances et applications pratiques

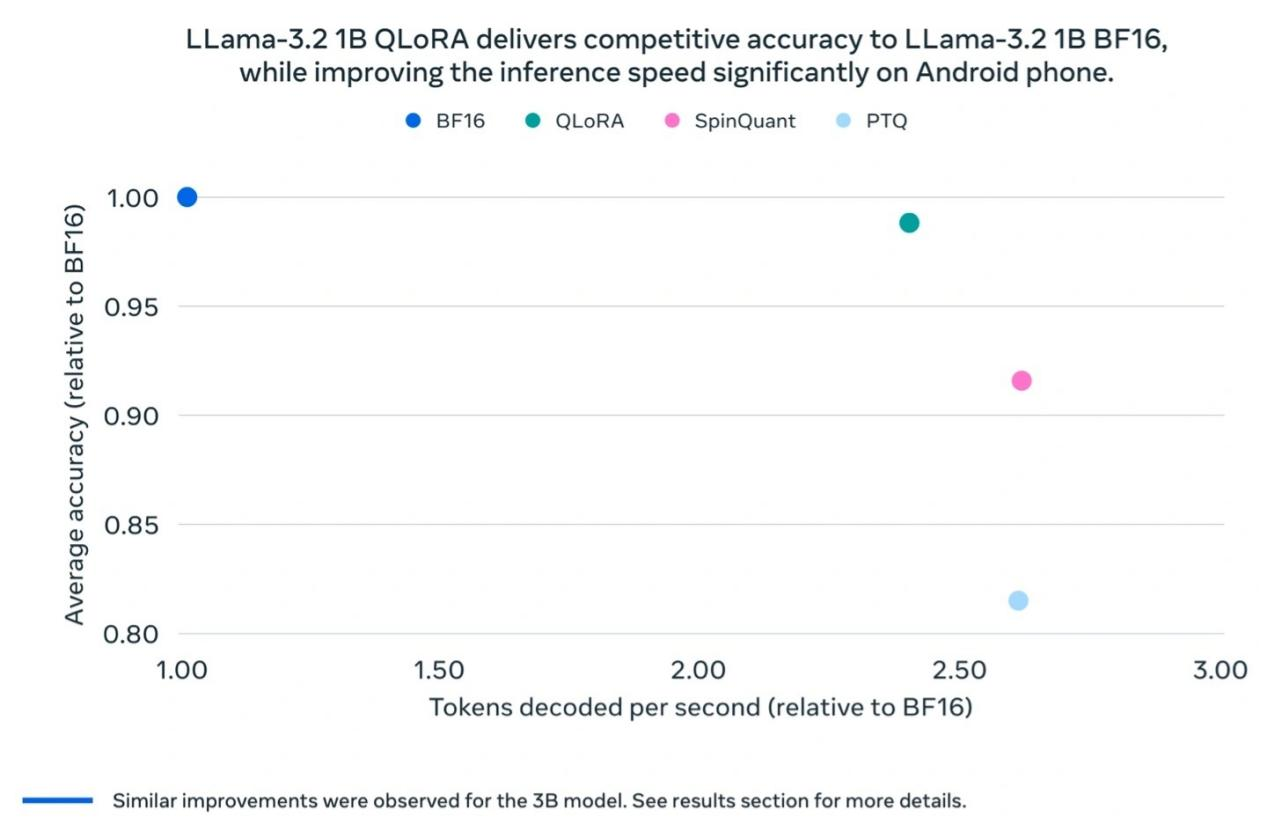

Les tests de Meta ont révélé que le modèle Llama 3.2 1B quantifié présente des améliorations significatives en termes de vitesse, d'utilisation de la RAM et de consommation d'énergie par rapport au modèle Llama BF16, tout en maintenant une précision presque identique à la version Llama BF16. Bien que le modèle quantifié soit limité à 8000 tokens (la version originale en supporte 128 000), les résultats des tests de référence montrent que les performances réelles de la version quantifiée restent proches de Llama BF16, améliorant considérablement son utilité pratique.

Meta a également effectué des tests sur le terrain sur plusieurs plateformes mobiles (y compris OnePlus 12, Samsung S24+/S22 et des appareils Apple iOS non divulgués), montrant des résultats de "bon fonctionnement", ce qui pose les bases du succès du modèle Llama 3.2 1B dans les applications du monde réel.

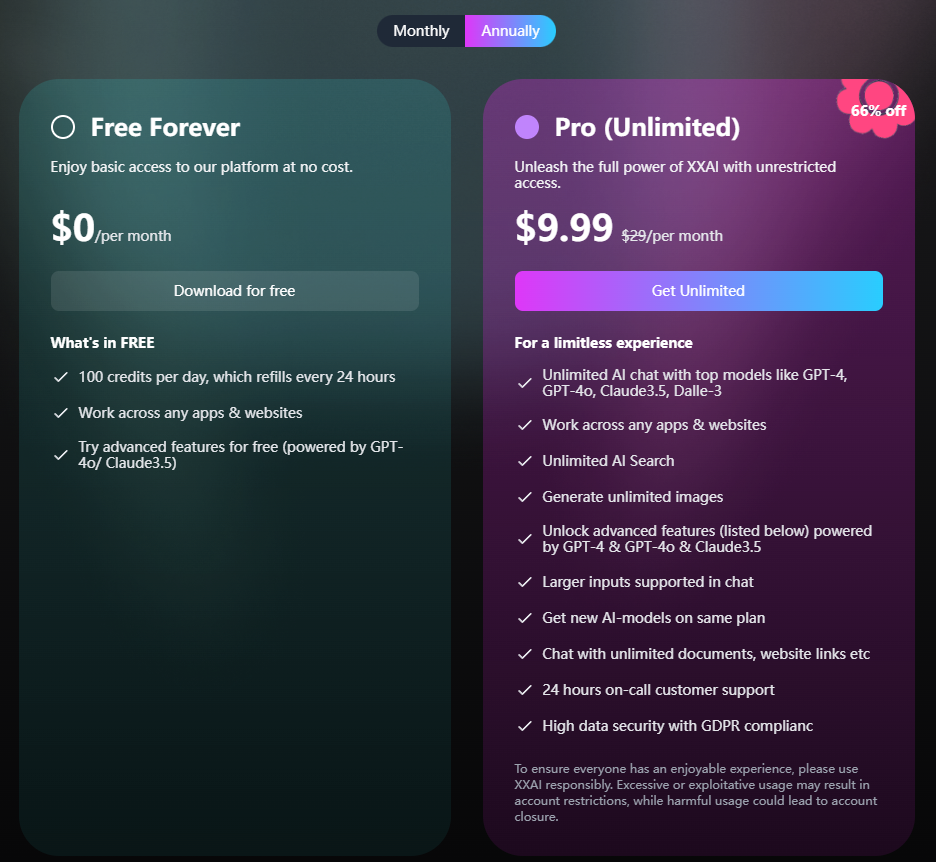

XXAI va introduire plus de modèles d'IA

Le logiciel d'assistant IA XXAI est sur le point de recevoir une grande mise à jour. Dans cette mise à jour, XXAI introduira davantage de modèles d'IA de premier plan, incluant non seulement Llama 3.2 1B et Llama 3.2 3B mentionnés dans l'article, mais aussi des modèles d'IA bien classés sur le marché tels que Gemini pro 1.5, Grok2, et Claude 3 Opus. Ce qui est important, c'est qu'en termes de prix, XXAI maintient son tarif inchangé, avec un plan annuel coûtant seulement 9,9 dollars par mois, offrant aux utilisateurs la possibilité d'un accès illimité à l'IA de pointe à un prix abordable.

Conclusion

Les versions quantifiées de Llama 3.2 1B et Llama 3.2 3B sont un exemple de réussite dans l'équilibre entre l'amélioration des performances et l'efficacité énergétique. Cette innovation favorisera l'application généralisée de la technologie d'intelligence artificielle sur les appareils mobiles, permettant à un nombre croissant d'applications intelligentes de fonctionner en douceur sur des appareils aux ressources limitées. Alors que Meta continue d'explorer et de repousser les limites, il ne fait aucun doute que les futurs appareils intelligents joueront un rôle encore plus important dans divers domaines.