Une présentation de Gemini 2.0 Flash et Pro et comment l'essayer gratuitement

Après la publication de DeepSeek-R1 et d'o3-mini d'OpenAI, Google a officiellement lancé l'ensemble des modèles de la série Gemini 2.0. La série 2.0 "est construite avec une nouvelle technologie d'apprentissage renforcé, utilisant Gemini lui-même pour évaluer ses réponses. Cela a produit des retours plus précis et ciblés, améliorant ainsi la capacité du modèle à traiter des requêtes sensibles. Le plus important est que ces modèles sont accessibles gratuitement sur Google Studio AI.

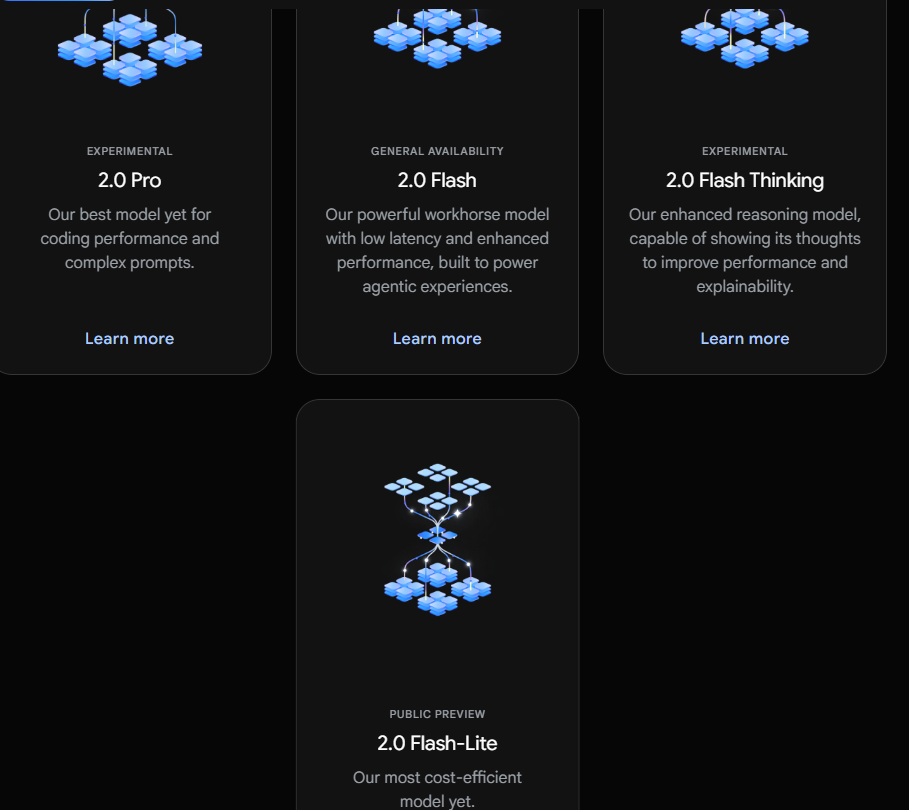

Caractéristiques de Gemini 2.0 Flash et Pro

● 2.0 Flash : il offre une interface API spécialement conçue pour les développeurs, permettant de construire rapidement des applications.

● 2.0 Flash-Lite : il réalise un meilleur rapport coût-performance et une plus grande vitesse de réponse tout en maintenant une haute performance.

● 2.0 Flash Thinking Experimental : il est ouvert aux utilisateurs dans l'application Gemini pour une expérience pratique.

● 2.0 Pro Experimental : il se concentre sur la performance en codage et la capacité à traiter des requêtes complexes, montrant d'excellentes performances en compréhension des connaissances et en raisonnement logique.

Fonctionnalités de Gemini 2.0 Flash et Pro

Gemini 2.0 Flash

Le modèle Gemini 2.0 Flash est adapté aux tâches à grande échelle et de haute fréquence, capable de traiter une fenêtre contextuelle allant jusqu'à 1 million de tokens, avec de puissantes capacités de raisonnement multimodal. Le modèle Gemini 2.0 Flash peut interagir avec des applications telles que YouTube, Google Search et Google Maps, aidant les utilisateurs à découvrir et à élargir leurs connaissances dans divers scénarios d'application. Ces applications connectées ont fait de l'application Gemini un assistant IA unique et utile.

Gemini 2.0 Flash-Lite

Le modèle 2.0 Flash-Lite prend en charge une fenêtre contextuelle de 1 million de tokens et des entrées multimodales, ainsi que des fonctionnalités de base telles que les sorties de texte et les appels de fonction. Il ne prend actuellement pas en charge les API multimodales en temps réel, les outils de recherche et l'exécution de code. Ce modèle est optimisé pour les cas d'utilisation de sortie de texte à grande échelle et a surpassé 1.5 Flash dans la plupart des tests de référence, tout en maintenant la vitesse et le coût appréciés par les développeurs.

Gemini 2.0 Flash Thinking Experimental

Le modèle 2.0 Flash Thinking Experimental prend en charge une fenêtre contextuelle de 1 million de tokens, permettant une analyse plus approfondie des longs textes. Il améliore non seulement la vitesse et les performances, mais excelle également dans les domaines scientifique et mathématique. Il possède des capacités de réflexion pour résoudre des problèmes complexes.

Le modèle Gemini 2.0 Flash Thinking est basé sur la rapidité et les performances de 2.0 Flash, ayant été formé pour décomposer les requêtes en une série d'étapes, renforçant ainsi ses capacités de raisonnement et fournissant des réponses de meilleure qualité.

Le modèle 2.0 Flash Thinking Experimental démontre son processus de pensée, permettant aux utilisateurs de comprendre pourquoi il répond d'une certaine manière, quelles sont ses hypothèses et de suivre la logique de raisonnement du modèle. Cette transparence permet aux utilisateurs de mieux comprendre le processus décisionnel du modèle.

Gemini 2.0 Pro Experimental

Le modèle 2.0 Pro Experimental excelle en programmation et peut répondre à des requêtes complexes. Ce modèle dispose d'une fenêtre contextuelle de 2 millions de tokens et prend en charge les entrées de texte, d'images, de vidéos et d'audios. Il peut analyser et comprendre une grande quantité d'informations de manière globale et prend en charge l'appel d'outils tels que Google Search et l'exécution de code.

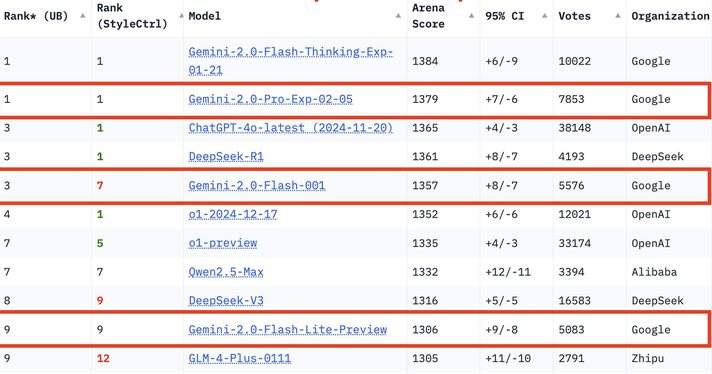

Résultats des tests de performance de la série Gemini 2.0

Dans la dernière арène des grands modèles, Gemini-2.0-Pro se classe en première position dans toutes les catégories, Gemini-2.0-Flash se classe troisième, et Flash-lite figure parmi les dix premiers grâce à sa performance exceptionnelle.

Lors du test MMLU-Pro, le 2.0 Pro Experimental a obtenu un score de 79,1 %, tandis que le 2.0 Flash Lite Preview et le 2.0 Flash GA ont obtenu respectivement 71,6 % et 77,6 %.

En ce qui concerne la génération de code, les mathématiques et les compétences multilingues, le 2.0 Pro Experimental se distingue également, en particulier dans les résultats en mathématiques (91,8 %) et en compétences multilingues (86,5 %).

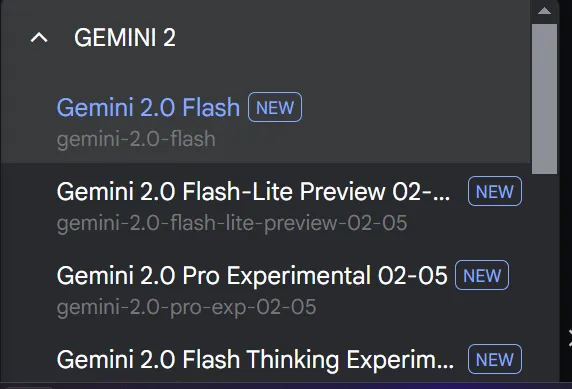

Comment utiliser gratuitement les modèles Google Gemini 2.0 Flash et Pro ?

- Connectez-vous à Google AI Studio.

- Allez pour créer les invites.

- Choisissez le modèle de votre préférence.

- Commencez la conversation.

XXAI reste à jour, s'optimise et améliore ses performances

toolpilot.ai offre aux utilisateurs une expérience de service de qualité et vérifie rigoureusement chaque outil d'IA. L'offre des outils d'IA sur la plateforme est constamment enrichie, permettant aux utilisateurs de trouver tous les outils d'IA nécessaires sur une seule plateforme. XXAI a terminé une série de mises à jour pour fournir une expérience utilisateur de qualité.

Cette mise à jour ajoute trois fonctionnalités importantes.

Fonction de recherche sur le Web : applicable à tous les modèles XXAI, supporte la recherche d'informations en temps réel sur Internet, fournissant un accès aux données les plus récentes pour garantir l'exactitude et la ponctualité des réponses, tout en incluant une fonction de validation des informations.

Fonction de pensée : offre des capacités d'analyse avancées similaires au modèle Gemini 2.0 Flash Thinking, supporte le raisonnement approfondi, résout des problèmes complexes et simule des modes de pensée humaine.

Recherche d'historique de chat : permet de rechercher facilement tous les précédents dialogues de chat, facilitant la recherche d'informations spécifiques à partir des interactions passées.

Avec cette mise à jour, XXAI vous propose des réponses plus complètes, des analyses plus approfondies, des informations plus précises et une meilleure expérience utilisateur.