Una descripción de Gemini 2.0 Flash y Pro y cómo probarlo gratuitamente

Después del lanzamiento de DeepSeek-R1 y o3-mini de OpenAI, Google ha lanzado oficialmente toda la serie de modelos Gemini 2.0. La serie 2.0 "está construida utilizando nuevas tecnologías de aprendizaje por refuerzo, empleando a Gemini mismo para criticar sus respuestas. Esto ha producido retroalimentación más precisa y dirigida, mejorando la capacidad del modelo para manejar consultas sensibles. Lo más importante es que estos modelos están disponibles de forma gratuita en Google Studio AI.

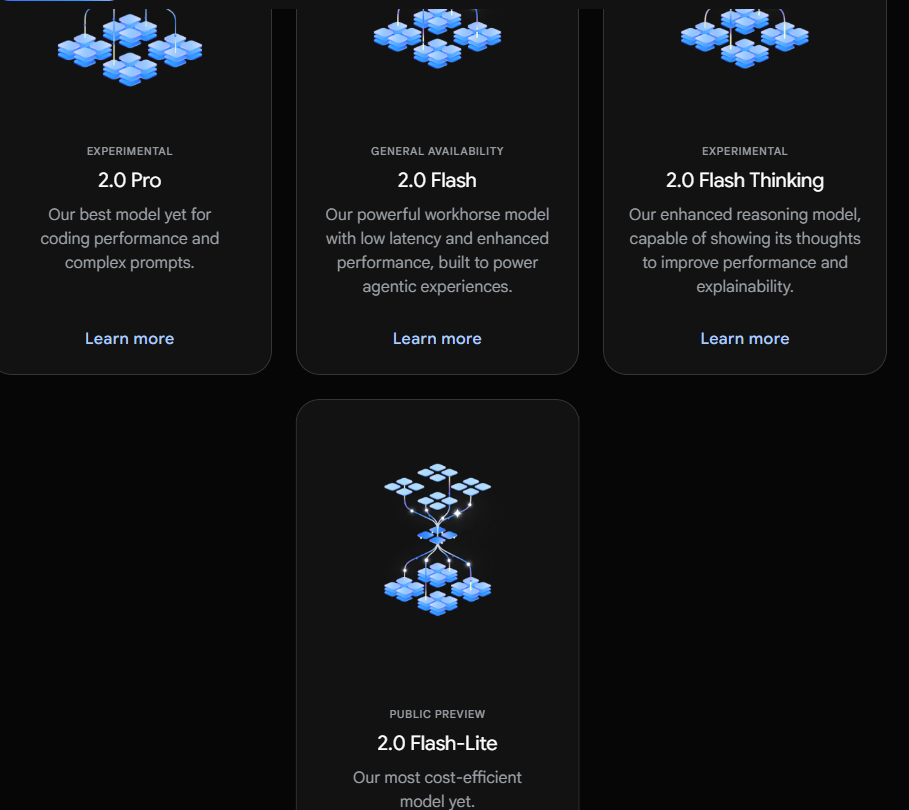

Características de Gemini 2.0 Flash y Pro

● 2.0 Flash: ofrece una interfaz de API diseñada especialmente para desarrolladores, permitiendo construir aplicaciones de forma rápida.

● 2.0 Flash-Lite: logra una mejor relación costo-rendimiento y una mayor velocidad de respuesta manteniendo un alto nivel de rendimiento.

● 2.0 Flash Thinking Experimental: está disponible en la aplicación Gemini para la experiencia del usuario.

● 2.0 Pro Experimental: se enfoca en el rendimiento de codificación y la capacidad para manejar consultas complejas, mostrando un excelente desempeño en comprensión de conocimientos y razonamiento lógico.

Funcionalidades de Gemini 2.0 Flash y Pro

Gemini 2.0 Flash

El modelo Gemini 2.0 Flash es adecuado para tareas de gran escala y alta frecuencia, capaz de manejar una ventana de contexto de hasta 1 millón de tokens, con potentes habilidades de razonamiento multimodal. El modelo Gemini 2.0 Flash puede interactuar con aplicaciones como YouTube, Google Search y Google Maps, ayudando a los usuarios a descubrir y expandir conocimientos en varios escenarios de aplicación. Estas aplicaciones conectadas han convertido a la aplicación Gemini en un asistente de IA único y útil.

Gemini 2.0 Flash-Lite

El modelo 2.0 Flash-Lite soporta una ventana de contexto de 1 millón de tokens y entradas multimodales, así como características básicas como salida de texto y llamadas a funciones. Actualmente, no admite API multimodal en tiempo real, herramientas de búsqueda y ejecución de código. Este modelo está optimizado para casos de uso de salida de texto a gran escala y ha superado al 1.5 Flash en la mayoría de las pruebas de referencia, manteniendo la velocidad y los costos que los desarrolladores valoran.

Gemini 2.0 Flash Thinking Experimental

El modelo 2.0 Flash Thinking Experimental admite una ventana de contexto de 1 millón de tokens, permitiendo un análisis más profundo de textos largos. Mejora no solo la velocidad y el rendimiento, sino que también se destaca en las áreas de ciencia y matemáticas. Tiene habilidades de razonamiento para resolver problemas complejos.

El modelo Gemini 2.0 Flash Thinking se basa en la velocidad y el rendimiento del 2.0 Flash, entrenado para descomponer las consultas en una serie de pasos, lo que refuerza sus capacidades de razonamiento y proporciona respuestas de mayor calidad.

El modelo 2.0 Flash Thinking Experimental demuestra su proceso de pensamiento, permitiendo a los usuarios ver por qué responde de cierta forma, cuáles son sus suposiciones y rastrear la lógica de razonamiento del modelo. Esta transparencia permite a los usuarios comprender mejor el proceso de toma de decisiones del modelo.

Gemini 2.0 Pro Experimental

El modelo 2.0 Pro Experimental es experto en programación y puede responder a consultas complejas. Este modelo tiene una ventana de contexto de 2 millones de tokens y admite entradas de texto, imágenes, videos y audio. Puede analizar y comprender grandes cantidades de información de manera integral y admite la invocación de herramientas como Google Search y la ejecución de código.

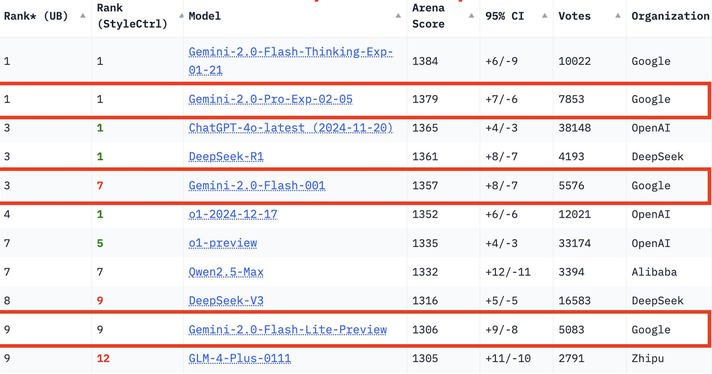

Resultados de las pruebas de rendimiento de la serie Gemini 2.0

En la última competencia de grandes modelos, Gemini-2.0-Pro ocupa el primer lugar en todas las categorías, Gemini-2.0-Flash ocupa el tercer lugar, y Flash-lite se encuentra entre los diez primeros debido a su excelente relación costo-rendimiento.

En la prueba MMLU-Pro, el 2.0 Pro Experimental obtuvo un puntaje del 79.1%, mientras que el 2.0 Flash Lite Preview y el 2.0 Flash GA obtuvieron puntajes de 71.6% y 77.6%, respectivamente.

En términos de generación de código, matemáticas y habilidades multilingües, el 2.0 Pro Experimental también muestra un excelente desempeño, destacándose especialmente en matemáticas (91.8%) y habilidades multilingües (86.5%).

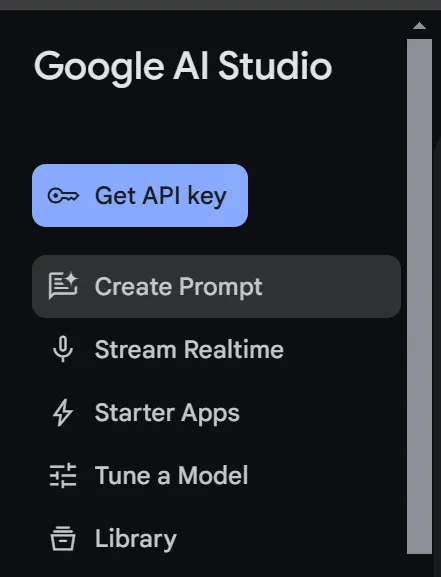

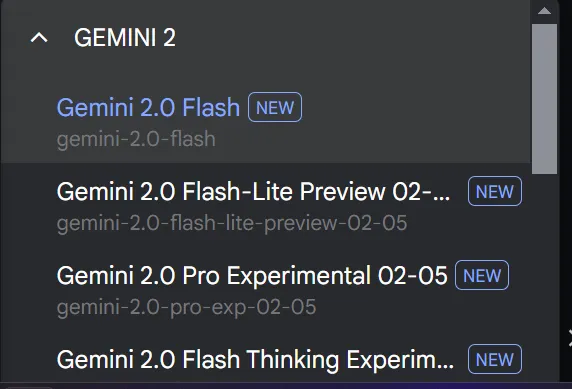

¿Cómo utilizar los modelos Google Gemini 2.0 Flash y Pro de forma gratuita?

- Inicie sesión en Google AI Studio.

- Vaya a crear mensajes.

- Elija el modelo que prefiera.

- Comience el chat.

XXAI se mantiene actualizado, optimiza y mejora rendimiento

toolpilot.ai ofrece a los usuarios una experiencia de servicio de calidad y revisa rigurosamente cada herramienta de IA. La oferta de herramientas de IA en el sitio se enriquece constantemente, permitiendo a los usuarios encontrar todas las herramientas de IA necesarias en una sola plataforma. XXAI ha completado un ciclo de actualizaciones para proporcionar una experiencia de servicio de calidad.

Esta actualización añade tres características importantes.

Función de búsqueda en la web: aplicable a todos los modelos de XXAI, admite la búsqueda de información en tiempo real en Internet, proporcionando acceso a los datos más recientes, garantizando la exactitud y la puntualidad de las respuestas, además de incluir una capacidad de validación de información.

Función de razonamiento: proporciona capacidades de análisis avanzadas similares a las del modelo Gemini 2.0 Flash Thinking, soporta razonamiento profundo, resuelve problemas complejos y simula patrones de pensamiento humano.

Búsqueda del historial de chat: permite buscar fácilmente todos los diálogos de chat anteriores, facilitando la búsqueda de información específica de interacciones pasadas.

Con esta actualización, XXAI le ofrece respuestas más completas, análisis más profundos, información más precisa y una mejor experiencia de usuario.