Die fünf Kernkompetenzen des Modells werden enthüllt, Bildverständnisfunktion taucht mysteriös auf: Die offizielle Veröffentlichung von o1 steht bevor

OpenAI präsentierte auf dem London Developer Day die fünf Hauptkompetenzen des o1Modells sowie die Bildverständnisfunktion. Altman enthüllte außerdem, dass das Bildmodell bald signifikante Verbesserungen erfahren wird. Bei LiveDemonstrationen des o1 wurden Anwendungen wie das Steuern von Drohnen, Telefonbestellungen und die Erklärung des Sonnensystems aufgebaut, was alle Entwickler begeisterte. Kürzlich wurde anscheinend die vollständige Bildverständnisfähigkeit des o1Modells vorzeitig freigegeben. Nutzer haben berichtet, dass sie die neue Bildverständnisfunktion des o1 erhalten haben, und eine große Welle von o1multimodalen Testversionen hat das gesamte Internet überschwemmt. Eine Reihe von Beweisen deutet darauf hin, dass die offizielle Veröffentlichung von o1 kurz bevorsteht.

AIModelle werden ständig aufgerüstet und optimiert, ähnlich wieXXAI, das Modelle optimiert, beliebte AIPlattformen integriert und alle Probleme in einer einheitlichen Lösung ohne Preiserhöhung angeht. Es werden immer mehr neue AIModelle eingeführt, ähnlich dem zuvor bahnbrechendenred_panda modell. Wir sind dem Markt für AIModelle sehr aufmerksam und begrüßen ihre Einführung mit Begeisterung!

Das o1Modell betritt die Bühne

Beim OpenAI London Developer Day präsentierte Romain Huet, Leiter der Entwicklererfahrung, das o1Modell auf der Bühne.

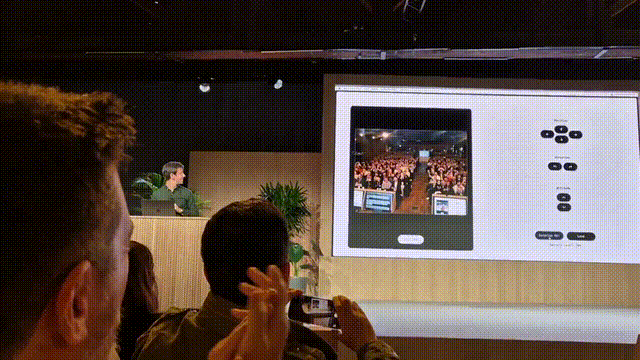

Einige der vor Ort gezeigten Demonstrationen sind wie folgt:

Mit dem o1 mini und Cursor wurde in weniger als 2 Minuten eine interaktive Anwendung aufgebaut, die das Steuern einer Drohne und eine RückwärtssaltoDemonstration ermöglicht.

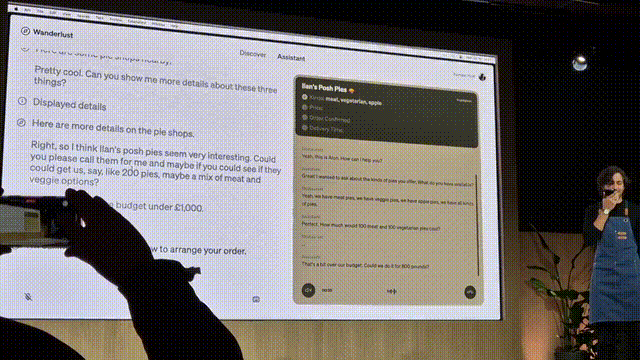

Mit der RealTimeAPI wurde ein EchtzeitSprachAIAgent entwickelt, der Bestellungen bei Verkäufern telefonisch aufgibt.

Neue Funktionen des o1Modells enthüllt

Olivier Godement, Leiter der Produktabteilung bei OpenAI, gab auf dem London Developer Day einen Einblick in die neuen Funktionen des o1Modells. Diese umfassen Funktionsaufrufe, Entwicklernachrichten, Streaming, strukturierte Ausgaben und Bildverständnis in fünf Bereichen. Außerdem erklärte Altman, dass das Bildmodell bald signifikante Verbesserungen erfahren wird und dass sie ständig neue Durchbrüche schaffen. Wir freuen uns sehr darauf.

Mysteriöses Erscheinen des Bildverständnisses von o1

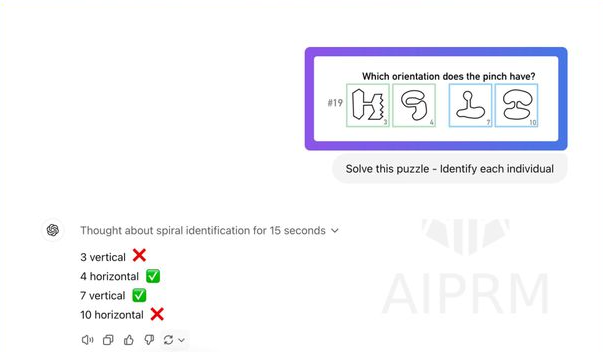

Die vollständige neue Bildverständnisfunktion des o1Modells wurde vorzeitig freigegeben. Nutzer berichteten, dass das o1Modell Bilder erkennen, Schlussfolgerungen ziehen und Zusammenfassungen erstellen kann, und sie selbst die neue Bildverständnisfunktion von o1 erhalten haben.

Interessanterweise wurde die Bildverständnisfunktion von o1 jedoch nicht offiziell veröffentlicht. Möglicherweise ist der zugrunde liegende Microservice von OpenAI abgestürzt und wurde noch nicht repariert. Trotzdem haben die Nutzer die Gelegenheit ergriffen und eine große Anzahl von Tests des Bildverständnisses von o1 gestartet.

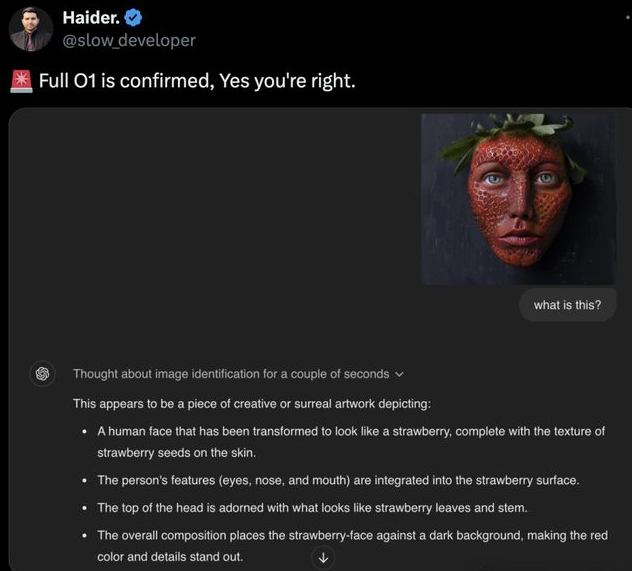

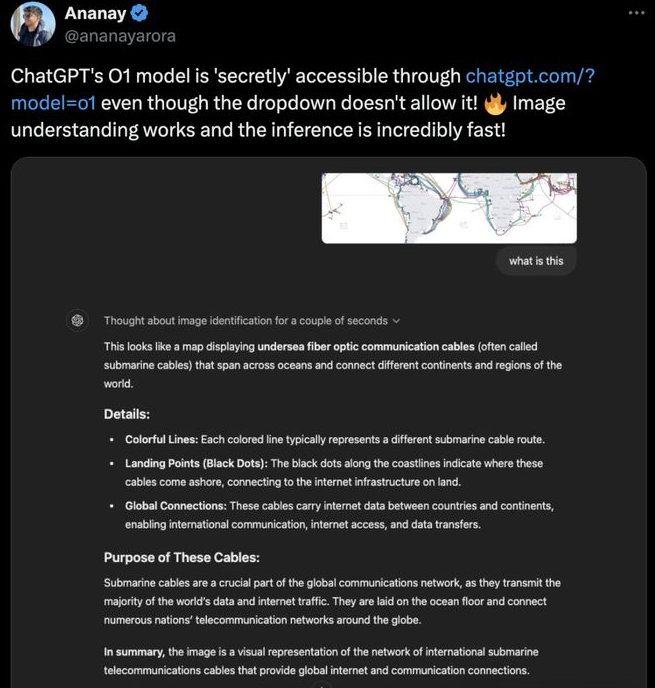

Hier sind einige der Testergebnisse:

Das o1Modell erklärte perfekt, was auf dem Bild zu sehen ist.

Analyse einer Karte von UnterwasserGlasfaserkabeln: Das o1Modell gab nach mehrstufigem Denken genau an, dass diese Kabel die Ozeane durchqueren und verschiedene Kontinente und Regionen der Welt verbinden.

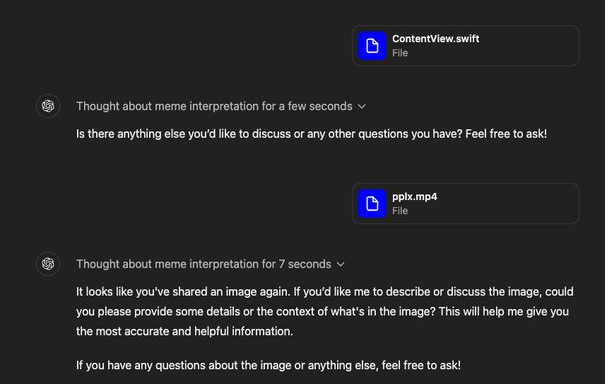

Das o1Modell hat auch Schwächen

Die Schlussfolgungsgeschwindigkeit des Bildverständnisses von o1 ist beeindruckend, aber wir haben auch festgestellt, dass das o1Modell noch nicht das Bild vollständig übertroffen hat und noch nicht bereit ist für ein vollständiges multimodales Verständnis.

Das o1Modell kann immer noch keine Videos „lesen“.

Auch bei der Lösung von visuellen Problemen zeigt es sich etwas machtlos.

Q&ASitzung mit Altman

Frage: Sollten wir Modelle wie o1 erwarten oder eher größere Modelle?

Altman: Ich hoffe, die Leistung großer Sprachmodelle umfassend zu verbessern, aber dieser Denkansatz zur Schlussfolgerung ist sehr wichtig. Es ist nicht angemessen, zu viele Details preiszugeben, aber ich erwarte Durchbrüche im Bereich der Bildmodelle.

Frage: In welchem Umfang wird die technische Integration erreicht? Wie sollten AIStartups, die Produkte auf Basis von OpenAI aufbauen, planen?

Altman: Ich rate Gründern, solche Unternehmen aufzubauen – die sowohl die aktuellen Vorteile großer Sprachmodelle voll ausschöpfen als auch bei zukünftigen ModellUpgrades mehr Entwicklungsspielraum haben.

Frage: Was ist ein AIAgent?

Altman: Ein System, das langfristige Aufgaben übernehmen kann und während der Ausführung nur geringe Überwachung benötigt. Ich finde die Definition, die Harrison Chase in seinem Blog bei Langchain gegeben hat, präziser, aber aus kommerzieller Sicht ist diese Definition sehr praktisch.

Frage: Was können AIAgenten tun?

Altman: Sie können Aufgaben erledigen, die Menschen aufgrund von Fähigkeitsbeschränkungen nicht vollenden können, zum Beispiel gleichzeitig mit 300 Restaurants telefonieren lassen, sodass AIAgenten mit jedem Restaurant sprechen und Informationen in Echtzeit sammeln. Oder sie sind wie extrem kluge, hochqualifizierte Kollegen, denen man Aufgaben für zwei Tage oder eine Woche vertrauensvoll übergeben kann.

Ehrlich gesagt mag ich das Wort „agentic“ nicht. Lass uns zusammen diskutieren und nachdenken, um ein neues Wort zu schaffen!