Eine Dokumentation zu Gemini 2.0 Flash und Pro und wie man es kostenlos testen kann

Nach der Veröffentlichung von DeepSeek-R1 und OpenAIs o3-mini hat Google offiziell die gesamte Serie des Gemini 2.0-Modells eingeführt. Die 2.0-Serie "wurde unter Verwendung neuer verstärkender Lerntechnologien entwickelt und nutzt Gemini selbst, um auf seine Reaktionen zu reagieren. Dies hat genauere und gezieltere Rückmeldungen erzeugt, wodurch die Fähigkeit des Modells verbessert wurde, sensible Eingaben zu verarbeiten. Das Wichtigste ist, dass diese Modelle kostenlos über Google Studio AI zugänglich sind.

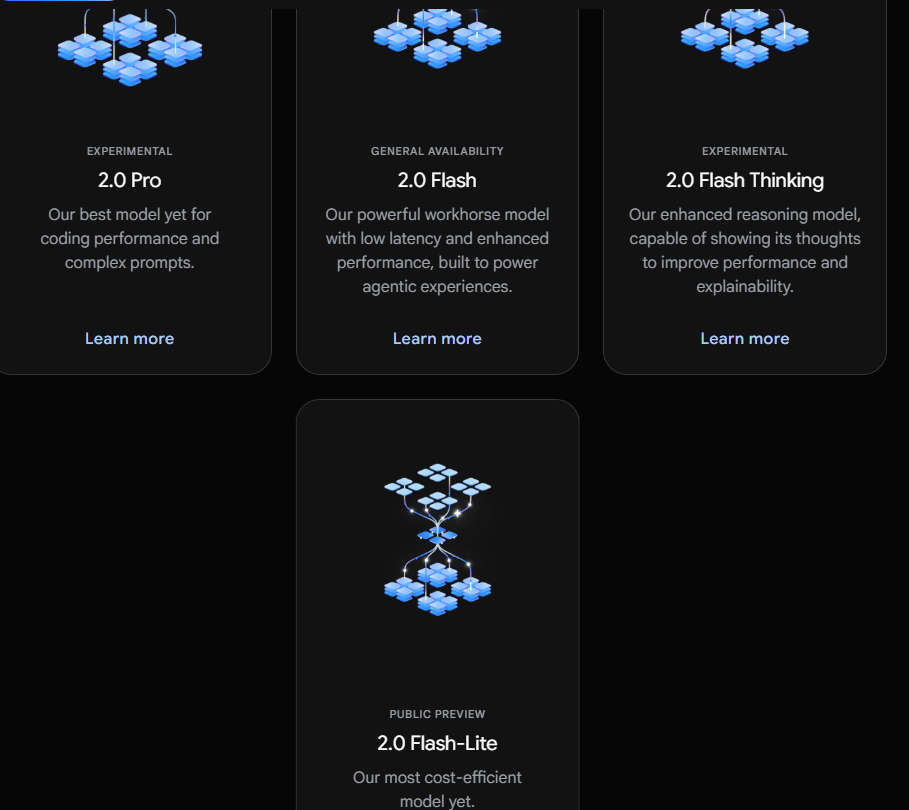

Eigenschaften von Gemini 2.0 Flash und Pro

● 2.0 Flash: Bietet speziell Entwicklern eine API-Schnittstelle zur schnellen Erstellung von Apps.

● 2.0 Flash-Lite: Erreicht ein besseres Kosten-Leistungs-Verhältnis und eine bessere Reaktionsgeschwindigkeit bei gleichzeitig hohem Leistungsniveau.

● 2.0 Flash Thinking Experimental: Ist in der Gemini-App für Benutzer zum Ausprobieren verfügbar.

● 2.0 Pro Experimental: Fokussiert auf Codierungsleistung und die Fähigkeit, komplexe Eingaben zu verarbeiten, und zeigt hervorragende Leistungen im Verständnis von Wissen und logischem Denken.

Funktionen von Gemini 2.0 Flash und Pro

Gemini 2.0 Flash

Das Gemini 2.0 Flash-Modell ist für groß angelegte, hochfrequente Aufgaben geeignet und kann einen Kontext von bis zu 1 Million Tokens verarbeiten, mit starken multimodalen Schlussfolgerungsfähigkeiten. Das Gemini 2.0 Flash-Modell kann mit Anwendungen wie YouTube, Google-Suche und Google Maps interagieren und den Nutzern helfen, in verschiedenen Anwendungsszenarien Wissen zu entdecken und zu erweitern. Diese verbundenen Anwendungen haben die Gemini-Anwendung zu einem einzigartigen und nützlichen KI-Assistenten gemacht.

Gemini 2.0 Flash-Lite

Das 2.0 Flash-Lite-Modell unterstützt einen Kontext von 1 Million Tokens und multimodalen Eingaben sowie Kernfunktionen wie Textausgabe und Funktionsaufrufen. Momentan werden Real-Time-APIs für multimodale Eingaben, Suchwerkzeuge und die Ausführung von Code nicht unterstützt. Dieses Modell wurde für groß angelegte Textausgabefälle optimiert und hat sich in den meisten Benchmark-Tests besser als 1.5 Flash geschlagen und behält die Geschwindigkeit und die Kosten, die Entwickler schätzen.

Gemini 2.0 Flash Thinking Experimental

Das 2.0 Flash Thinking Experimental-Modell unterstützt einen Kontext von 1 Million Tokens und erlaubt eine tiefere Analyse langer Texte. Es verbessert nicht nur Geschwindigkeit und Leistung, sondern glänzt auch in Wissenschaft und Mathematik. Es hat die Fähigkeit, komplexe Probleme zu lösen.

Das Gemini 2.0 Flash Thinking-Modell basiert auf der Geschwindigkeit und Leistung von 2.0 Flash und ist darauf trainiert, Eingaben in eine Reihe von Schritten zu zerlegen, wodurch seine Schlussfolgerungsfähigkeiten gestärkt und qualitativ hochwertige Antworten bereitgestellt werden.

Das 2.0 Flash Thinking Experimental-Modell zeigt seinen Denkprozess, sodass Benutzer sehen können, warum es auf eine bestimmte Weise reagiert, welche Annahmen es hat und wie die Schlussfolgerungslogik des Modells nachvollzogen werden kann. Diese Transparenz ermöglicht es Benutzern, den Entscheidungsprozess des Modells tiefer zu verstehen.

Gemini 2.0 Pro Experimental

Das 2.0 Pro Experimental-Modell ist gut im Programmieren und kann komplexe Eingaben beantworten. Dieses Modell verfügt über einen Kontext von 2 Millionen Tokens und unterstützt Eingaben in Text, Bildern, Videos und Audios. Es kann riesige Informationsmengen umfassend analysieren und verstehen und unterstützt die Verwendung von Tools wie Google-Suche und die Ausführung von Code.

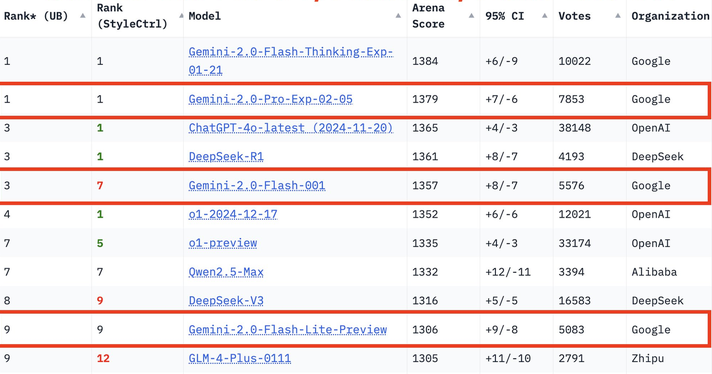

Leistungstests der Gemini 2.0 Serie

Im neuesten Wettbewerb um große Modelle belegt Gemini-2.0-Pro in allen Kategorien den 1. Platz, Gemini-2.0-Flash den 3. Platz und Flash-lite hat sich mit einem hervorragenden Preis-Leistungs-Verhältnis unter die Top Ten geschlagen.

Im MMLU-Pro-Test führt 2.0 Pro Experimental mit einer Punktzahl von 79,1 %, während 2.0 Flash Lite Preview und 2.0 Flash GA 71,6 % bzw. 77,6 % erzielen.

In Bezug auf Codegenerierung, Mathematik und Mehrsprachigkeitsfähigkeiten zeigt 2.0 Pro Experimental ebenfalls hervorragende Leistungen, insbesondere in Mathematik (91,8 %) und Mehrsprachigkeit (86,5 %).

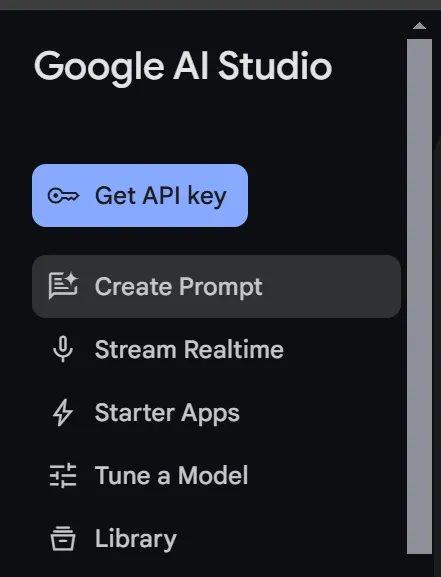

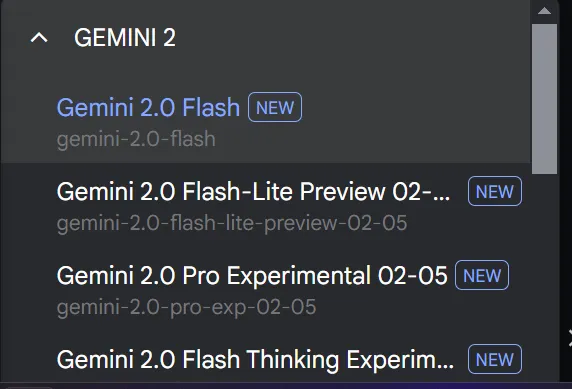

Wie kann man die Google Gemini 2.0 Flash- und Pro-Modelle kostenlos nutzen?

- Melden Sie sich bei Google AI Studio an.

- Gehen Sie zu den Eingabeaufforderungen.

- Wählen Sie das gewünschte Modell aus.

- Beginnen Sie den Chat.

XXAI bleibt auf dem Laufenden, optimiert und verbessert die Leistung

toolpilot.ai bietet den Benutzern ein hochwertiges Serviceerlebnis und überprüft jedes KI-Tool sorgfältig. Das Angebot an AI-Tools auf der Seite wird ständig bereichert, sodass Benutzer auf einer Plattform alle benötigten KI-Tools finden können. XXAI hat eine umfassende Aktualisierung durchgeführt, um den Benutzern ein hochwertiges Serviceerlebnis zu bieten.

Dieses Update bringt drei wichtige Funktionen hinzu.

Websuchfunktion: Gilt für alle XXAI-Modelle, unterstützt die Echtzeitsuche im Internet und bietet Zugriff auf die neuesten Daten, um die Genauigkeit und Aktualität der Antworten zu gewährleisten, auch mit Informationsvalidierungsfunktionen.

Denkfunktion: Bietet fortgeschrittene Analysefähigkeiten wie das Gemini 2.0 Flash Thinking-Modell, unterstützt tiefes Denken, löst komplexe Probleme und simuliert menschliche Denkweisen.

Chatverlaufssuche: Ermöglicht eine einfache Suche aller vorherigen Chat-Gespräche, sodass Benutzer spezifische Informationen aus früheren Interaktionen leicht finden können.

Durch dieses Upgrade bietet XXAI umfassendere Antworten, tiefere Analysen, genauere Informationen und ein besseres Benutzererlebnis.