Uma visão sobre Gemini 2.0 Flash e Pro e como experimentá-lo gratuitamente.

Após o lançamento do DeepSeek-R1 e do o3-mini da OpenAI, o Google lançou oficialmente toda a série de modelos Gemini 2.0. A série 2.0 "é construída usando novas tecnologias de aprendizado por reforço, utilizando o próprio Gemini para criticar suas reações. Isso produziu feedbacks mais precisos e direcionados, melhorando a capacidade do modelo de lidar com prompts sensíveis. O mais importante é que esses modelos estão acessíveis gratuitamente no Google Studio AI.

Características do Gemini 2.0 Flash e Pro

● 2.0 Flash: oferece uma interface de API projetada para desenvolvedores, permitindo a construção rápida de aplicativos.

● 2.0 Flash-Lite: atinge uma melhor relação custo-benefício e uma maior velocidade de resposta mantendo um alto desempenho.

● 2.0 Flash Thinking Experimental: está disponível no aplicativo Gemini para a experiência do usuário.

● 2.0 Pro Experimental: foca no desempenho de codificação e na capacidade de lidar com prompts complexos, demonstrando um excelente desempenho em compreensão de conhecimento e raciocínio lógico.

Funcionalidades do Gemini 2.0 Flash e Pro

Gemini 2.0 Flash

O modelo Gemini 2.0 Flash é adequado para tarefas em grande escala e alta frequência, capaz de lidar com uma janela de contexto de até 1 milhão de tokens, com poderosas habilidades de raciocínio multimodal. O modelo Gemini 2.0 Flash pode interagir com aplicativos como YouTube, Google Search e Google Maps, ajudando os usuários a descobrir e expandir o conhecimento em vários cenários de aplicação. Esses aplicativos conectados tornaram o aplicativo Gemini um assistente de IA único e útil.

Gemini 2.0 Flash-Lite

O modelo 2.0 Flash-Lite suporta uma janela de contexto de 1 milhão de tokens e entradas multimodais, bem como funcionalidades básicas como saída de texto e chamadas de função. Atualmente, não suporta APIs multimodais em tempo real, ferramentas de pesquisa e execução de código. Este modelo é otimizado para casos de uso de saída de texto em grande escala e superou o 1.5 Flash na maioria dos testes de referência, mantendo a velocidade e os custos que os desenvolvedores valorizam.

Gemini 2.0 Flash Thinking Experimental

O modelo 2.0 Flash Thinking Experimental suporta uma janela de contexto de 1 milhão de tokens, permitindo uma análise mais profunda de textos longos. Não apenas melhora a velocidade e o desempenho, mas também se destaca nas áreas de ciência e matemática. Possui habilidades de raciocínio para resolver problemas complexos.

O modelo Gemini 2.0 Flash Thinking é baseado na velocidade e desempenho do 2.0 Flash, tendo sido treinado para desmembrar os prompts em uma série de etapas, aumentando suas capacidades de raciocínio e fornecendo respostas de maior qualidade.

O modelo 2.0 Flash Thinking Experimental demonstra seu processo de pensamento, permitindo que os usuários vejam por que ele responde de determinada maneira, quais são suas suposições e rastreiam a lógica de raciocínio do modelo. Essa transparência permite que os usuários compreendam melhor o processo de decisão do modelo.

Gemini 2.0 Pro Experimental

O modelo 2.0 Pro Experimental é especializado em programação e pode responder a prompts complexos. Este modelo possui uma janela de contexto de 2 milhões de tokens e suporta entradas em texto, imagens, vídeos e áudios. Ele pode analisar e compreender grandes quantidades de informações de forma abrangente e apoia a invocação de ferramentas como Google Search e execução de código.

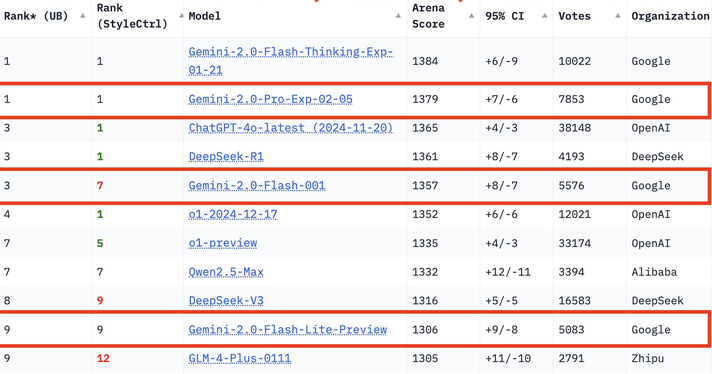

Resultados dos testes de desempenho da série Gemini 2.0

Na mais recente arena de grandes modelos, o Gemini-2.0-Pro ocupa o primeiro lugar em todas as categorias, o Gemini-2.0-Flash ocupa o terceiro lugar e o Flash-lite figura entre os dez primeiros devido ao seu excelente custo-benefício.

No teste MMLU-Pro, o 2.0 Pro Experimental obteve um pontuação de 79,1%, enquanto o 2.0 Flash Lite Preview e o 2.0 Flash GA obtiveram 71,6% e 77,6%, respectivamente.

Em questões de geração de código, matemática e habilidades multilíngues, o 2.0 Pro Experimental também apresenta excelente desempenho, especialmente em matemática (91,8%) e habilidades multilíngues (86,5%).

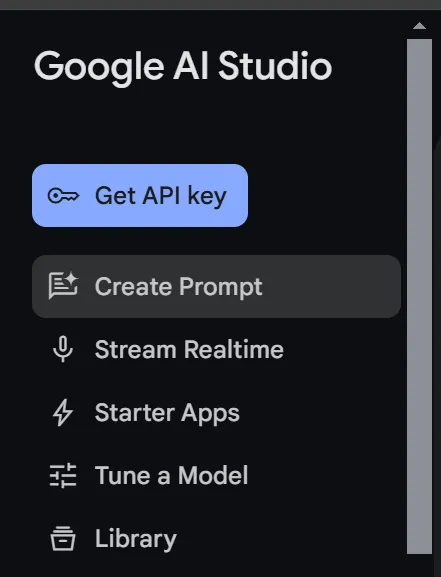

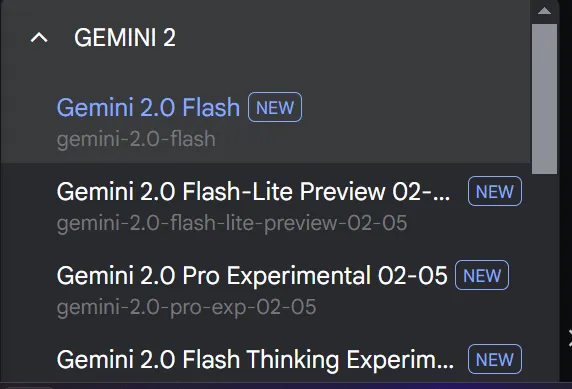

Como usar os modelos Google Gemini 2.0 Flash e Pro gratuitamente?

- Faça login no Google AI Studio.

- Vá para criar prompts.

- Escolha o modelo que preferir.

- Comece a conversa.

XXAI se mantém atualizado, otimiza e melhora o desempenho

toolpilot.aioferece aos usuários uma experiência de serviço de qualidade e analisa rigorosamente cada ferramenta de IA. O acervo de ferramentas de IA no site está constantemente sendo enriquecido, permitindo que os usuários encontrem todas as ferramentas de IA necessárias em uma única plataforma. O XXAI completou um ciclo de atualizações para fornecer uma experiência de serviço de qualidade.

Esta atualização adicionou três funcionalidades importantes.

Função de busca na web: aplicável a todos os modelos XXAI, suporta busca de informações em tempo real na internet, oferecendo acesso a dados mais recentes, garantindo a precisão e a pontualidade das respostas, além de incluir uma capacidade de validação de informações.

Função de raciocínio: oferece capacidades de análise avançadas semelhantes às do modelo Gemini 2.0 Flash Thinking, apoia raciocínio aprofundado, resolve problemas complexos e simula padrões de pensamento humano.

Busca no histórico de chat: permite buscar facilmente todos os diálogos de chat anteriores, facilitando a busca de informações específicas a partir de interações passadas.

Com essa atualização, o XXAI oferece respostas mais abrangentes, análises mais profundas, informações mais precisas e uma melhor experiência do usuário.